软件工程师罗小东,拥有多年架构和平台设计经验,目前专注于平台与新技术的融合研究。

概述

此为针对于AIP在项目团队上在Agent上的研究成果参考,临时手稿,会有一些口语化。

此次的升级,通过工具、数据、私有模型的结合,高质量的输出结果和场景结合,将为下一步形成自动化触发的做基础能力,比如根据环境感触自动执行任务输出结果(如环境感知→任务触发→结果输出闭环)。

针对的是AIP智能体平台的三四季度的规划,主要针对于落地和专业级Agent的能力提升,这里对专业级能力的理解是高级水平、高级能力,比如我要一份十几页Word技术方案,应该出来的就是一份高级水平的技术方案。

提升的基础在于在二三季度智能体和业务场景的落地经验,还有研究升级、探索经验上面,包括MCP平台、数据治理平台的可行性结合进行的规划。

这里提升主要基于三个部分:

- 数据资产化

- 私有模型专业化

- 工具链深度集成

前期聊过类似于Manus、扣子空间这样形态会后面持续一段时间,包括目前的天工智能体形态也类似,在进一步的研究提升上面,我们觉得思路是对的,但是过程和体现形式上,需要做一些流程上的优化能力,同时要足够聚焦,我们需要更聚焦的场景来体现Agent输出能力。

将结合数据、专业数据一起,以结果为主的交付,随着大模型生态发展和应用结合上的不断成熟,结果会越来越专业。每个架构师思想不一,我有我思,期望可以给一些同学更多的参考。

提升准备

前期的AIP平台的形成的基础能力,主要是基于这一层上面做的AI大模型原生应用:

- 智能体管理平台(全生命周期管理)

- 轻量级数据治理平台(数据资产化)

- 智能体应用客户端(多形态交互)

现有智能体输出形态已覆盖主流范式,集成的智能体输出形态,这里的形态指的是Agent设计思路,还有交互和输出模式,主要是智能体能力输出的体现:

- 单智能体输出形态

- 多智能体群形态

- 多智能体结合场景形态

- DeepSearch形态

- 规划与执行形态

- ReAct推理形态

- MCP工具集成形态

- Agentic智能体和RAG形态

对比开源或者市面上的智能体体现形态上来说,基本上大差不差,而可以使用更深入的方法论和理论,当前在集成过程中,需要更加的聚焦在业务能力和场景上,需要对Agent进一步的提升和落地能力,体现Agent价值。

提升方向

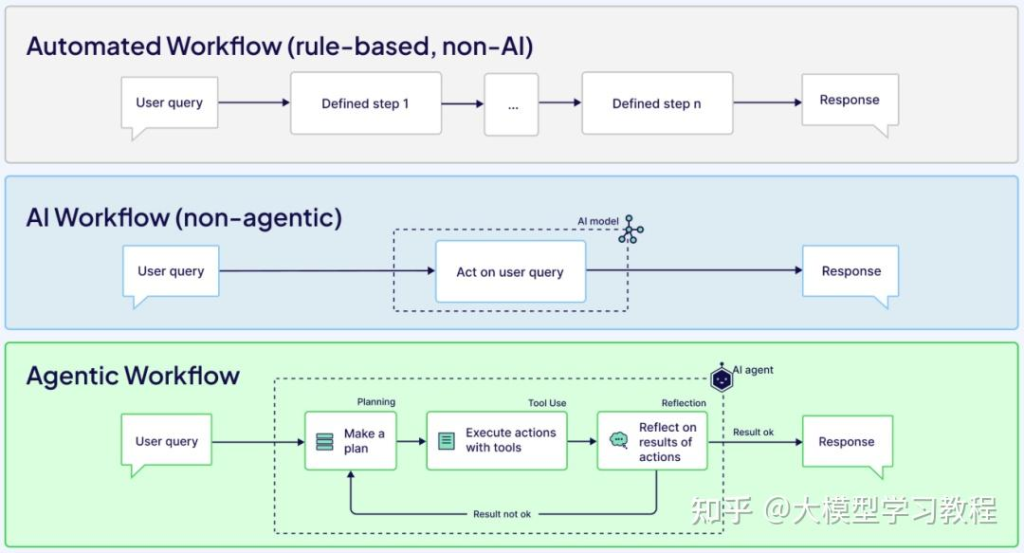

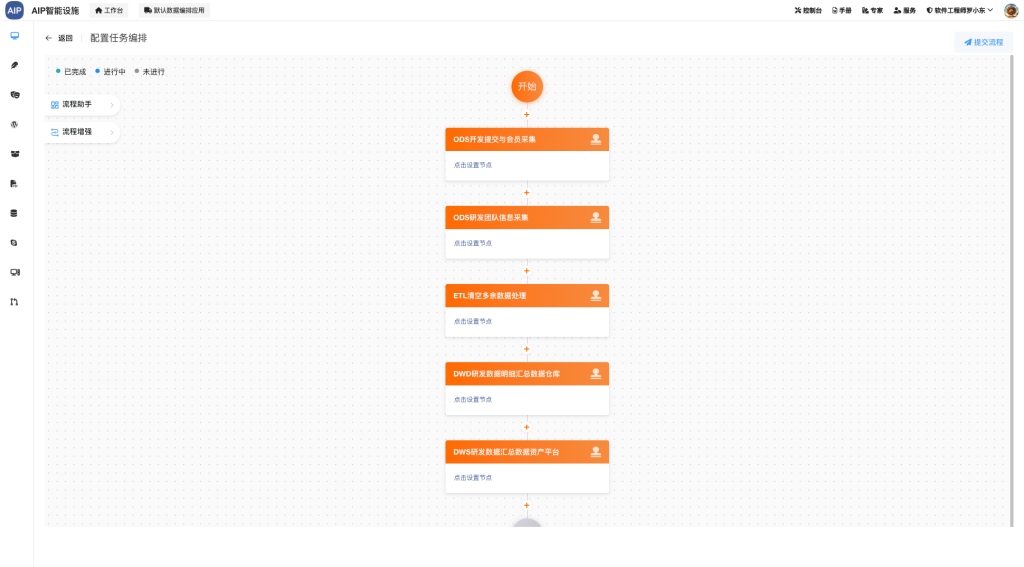

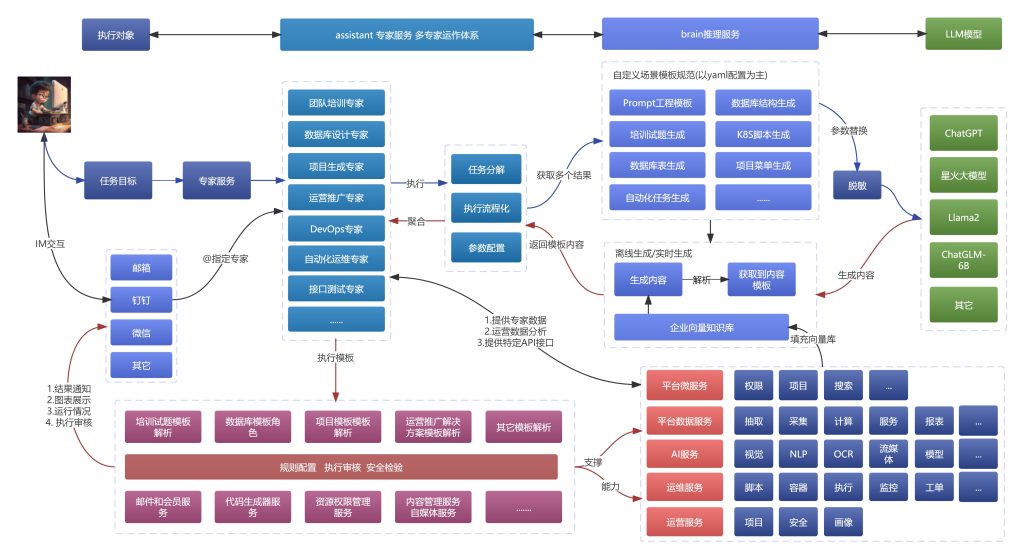

我们并没有使用AI工作流,而是使用”目标->推理->总结->判断是否符合->推理->符合->结束”这样的ReAct架构去完成任务。其实在这个模式下,结合MCP工具,结合出来的效果也不错的,但是需要更专业的智能体角色。

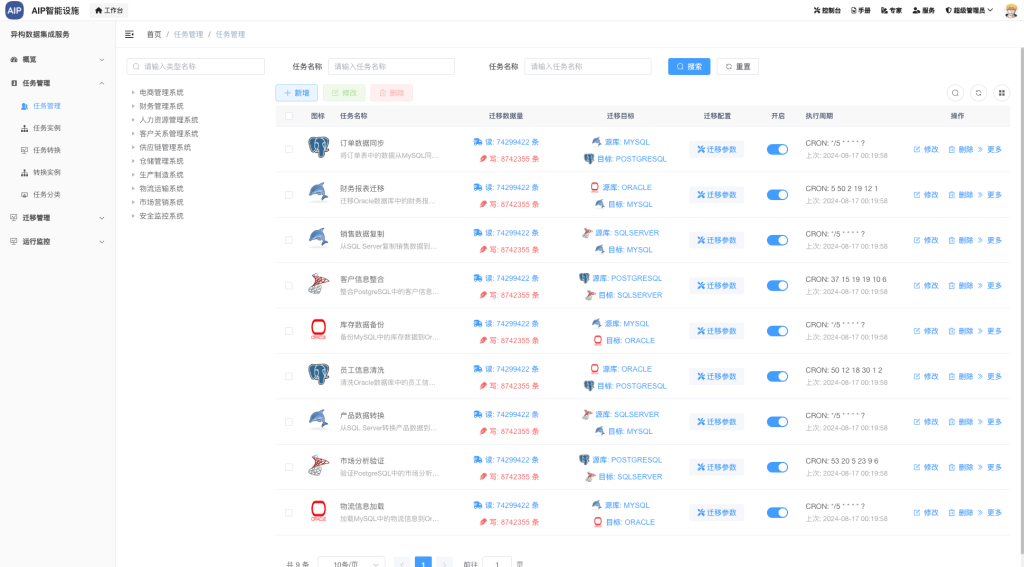

以下为数据资产化集成:

这里主要提升会针对于几个方面来着手,大模型聚焦在指定场景下,数据越专业、越实时,效果会越好,而在于工具都完善的情况下,提升的主要方向便是从数据上着手。

主要提升点:

- 数据资产化:每个Agent的知识库,从数据采集、清洗、再到资产化,形成近实时的状态,做好资产归纳分类

- 私有模型微调:规划每个场景下的私有大模型,并且私有部署,建立模型微调平台;

- 工具针对化:每个MCP工具针对性要强,与资产化,数据化的能力结合适当;

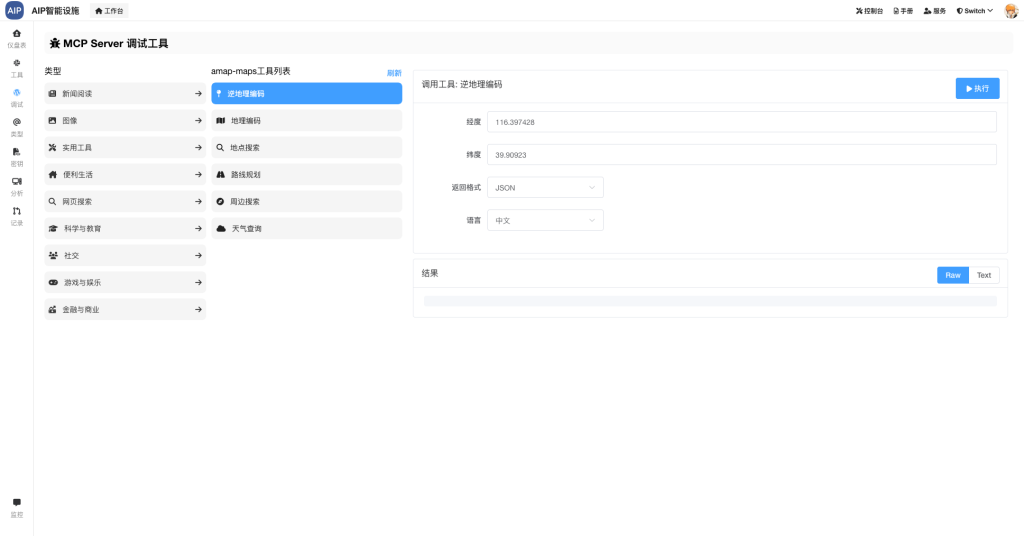

以下为MCP工具集成:

为了上面的落地更加顺利,我们会将业务场景固化,不是每个场景都需要通用,需要固化的场景来固化效果,重在输出结果,还有体现这个场景的价值。

产品形态

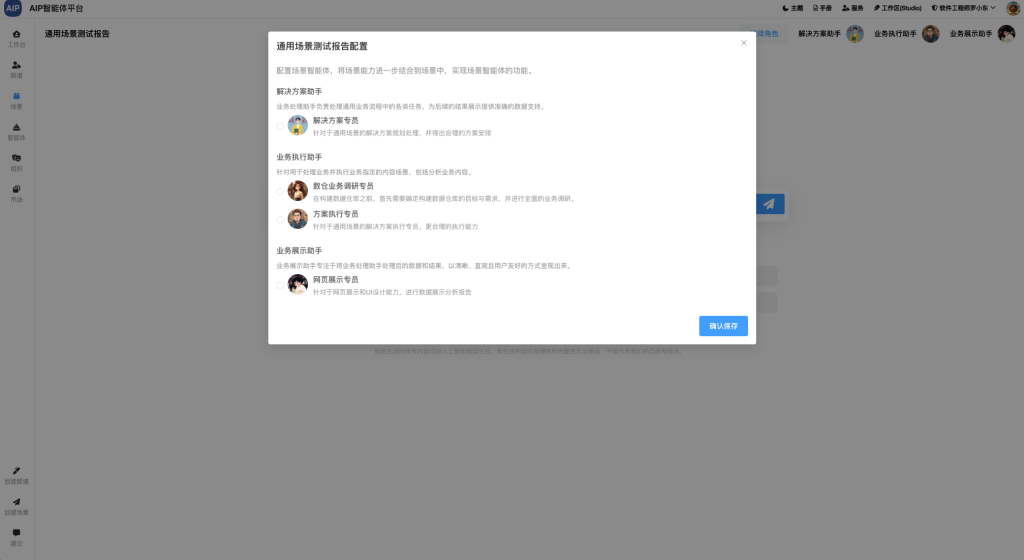

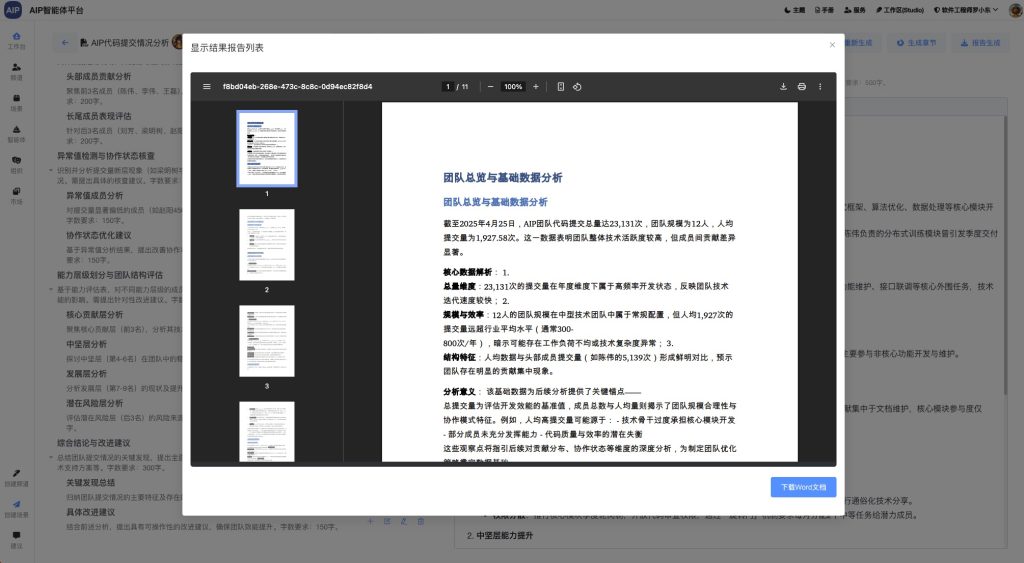

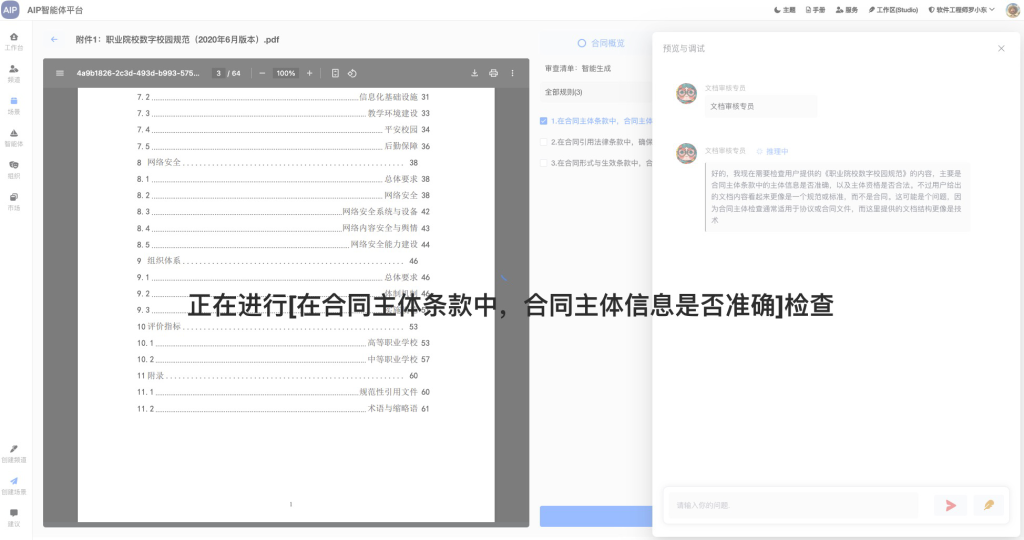

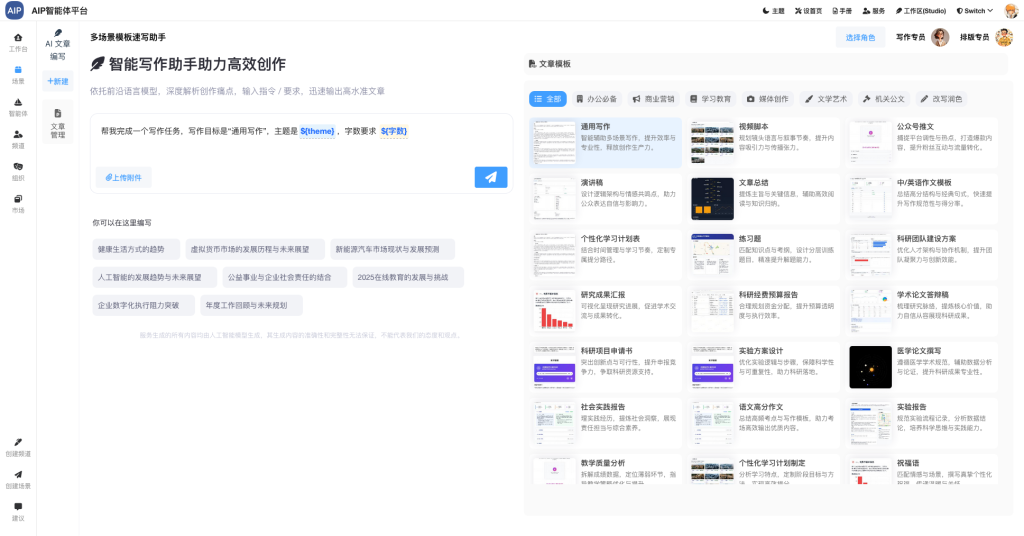

以下为我们过程中一些产品形态和体现,这里我们将Agent归纳为几种形态,当然,可以通过这几种形态变换不同的场景,其它新的形态,我们会使用新的应用开发AI原生应用,以下为常见的形态展示,列出几部分:

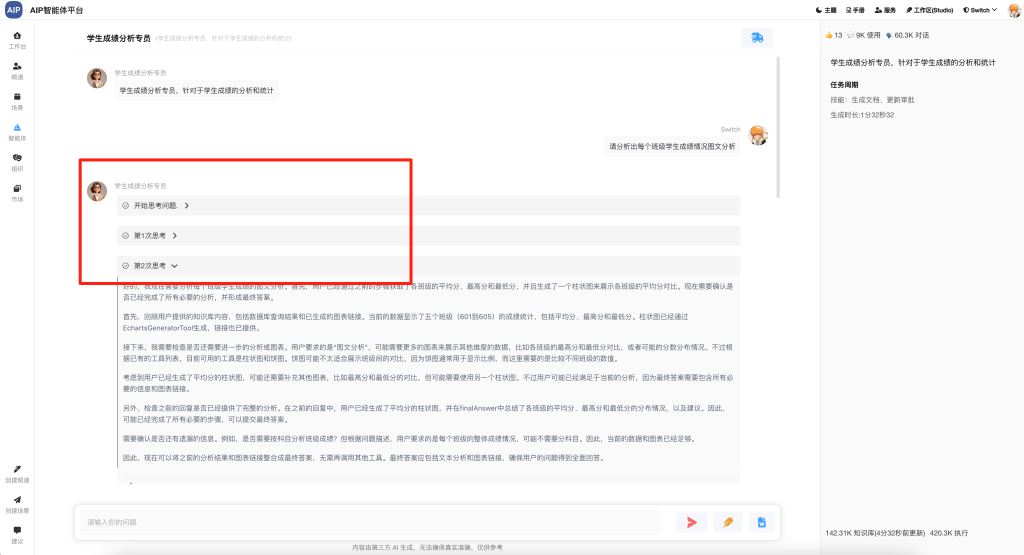

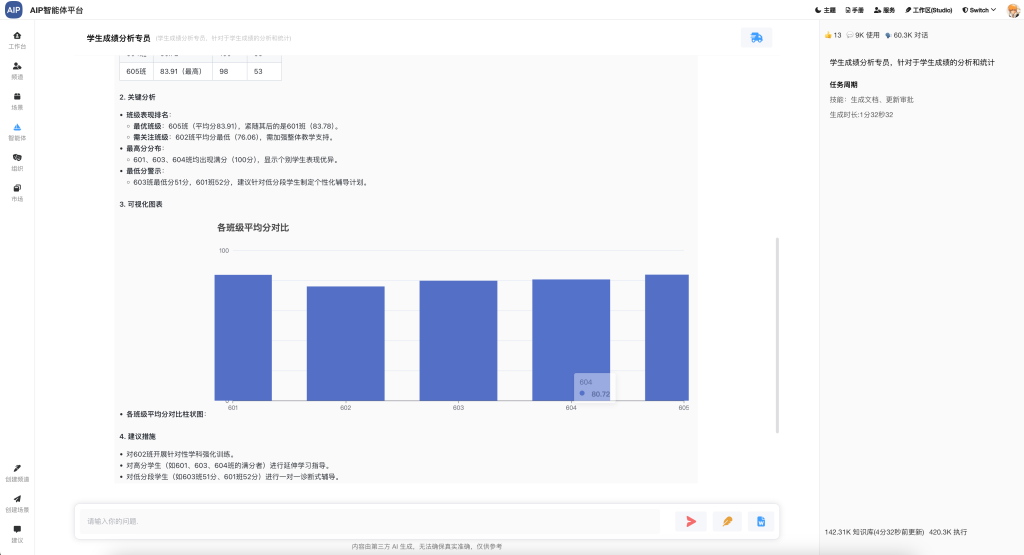

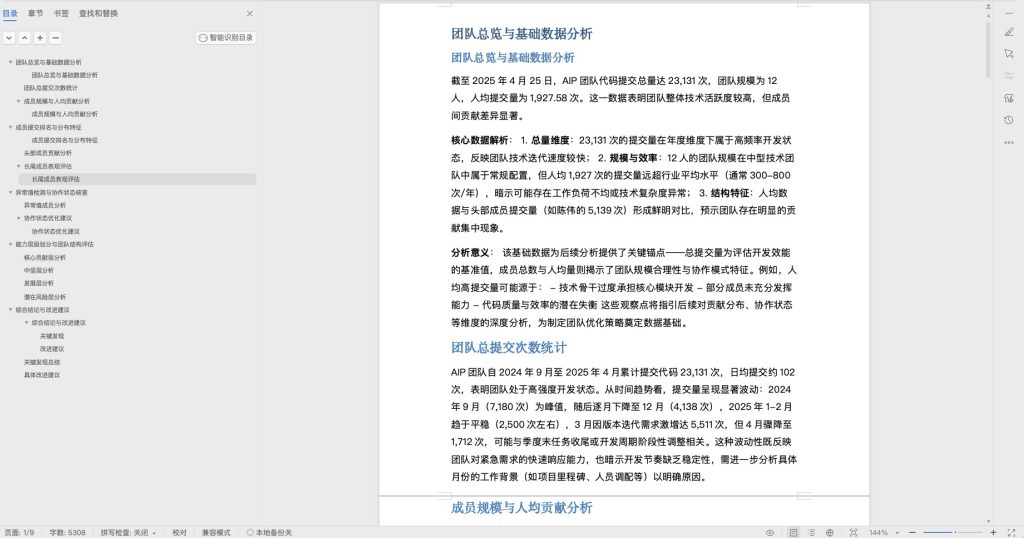

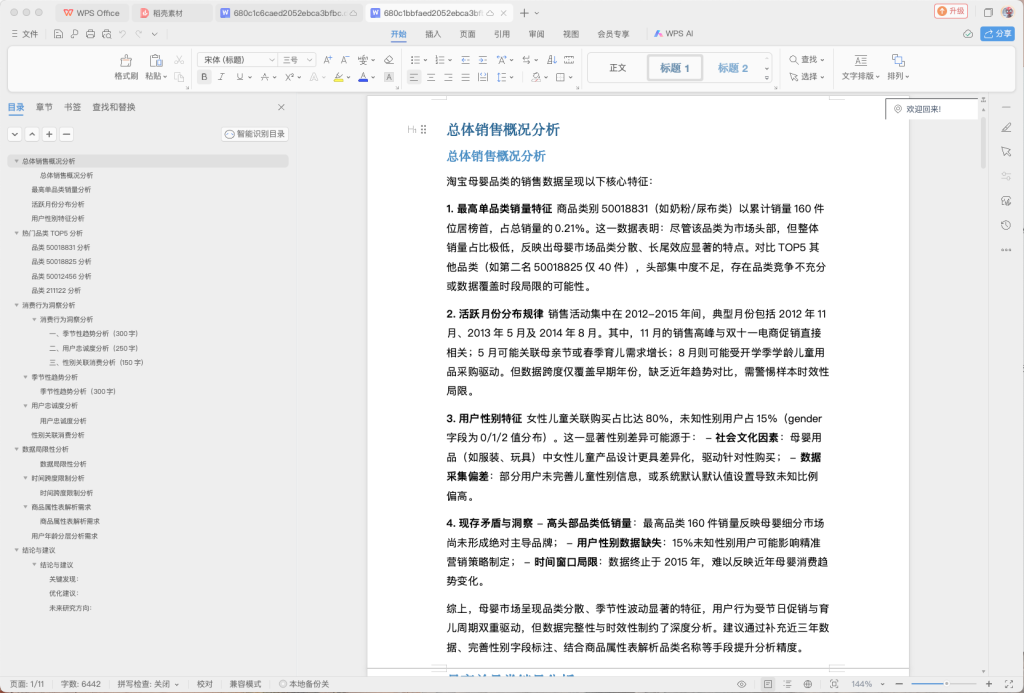

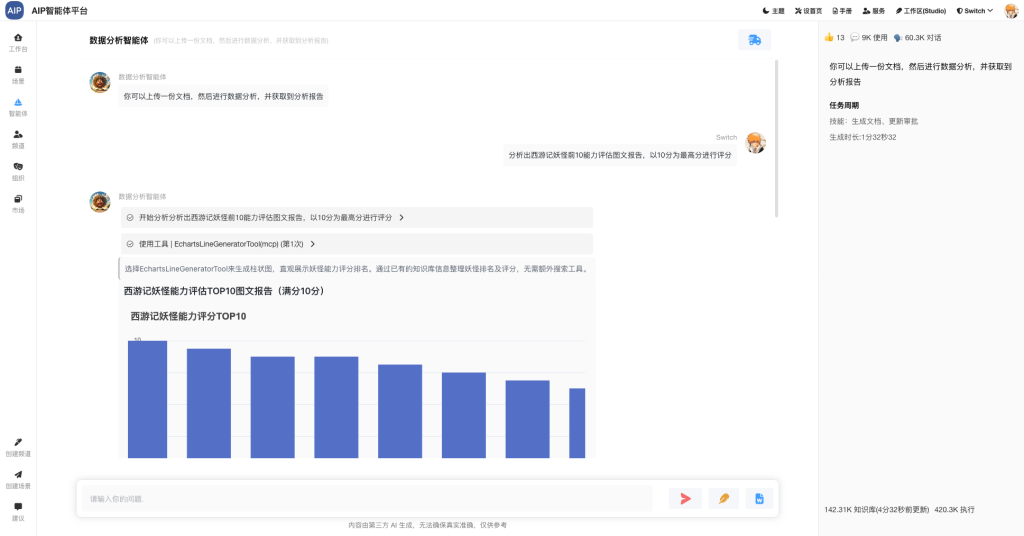

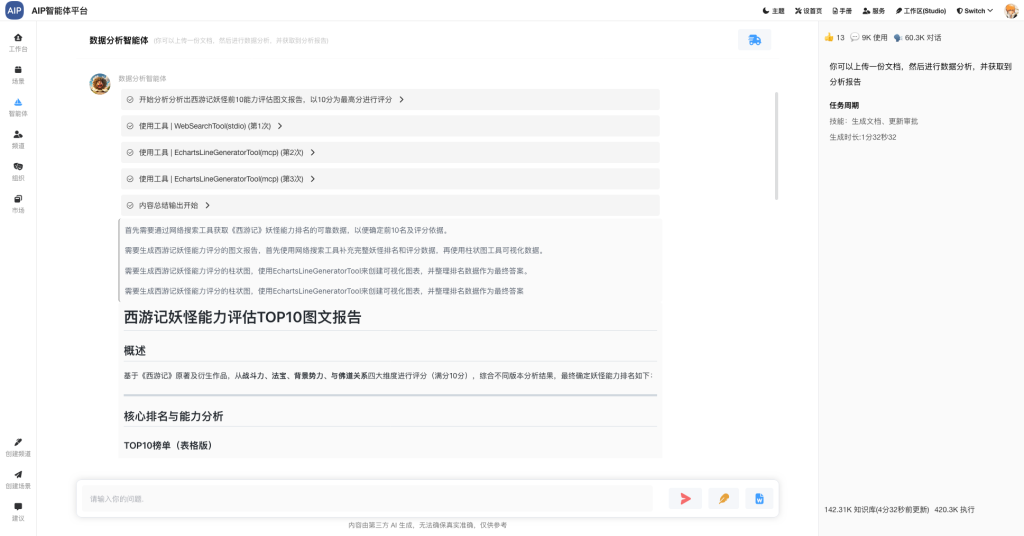

- 单智能体输出形态,这里以数据分析智能体和AIGC为示例:

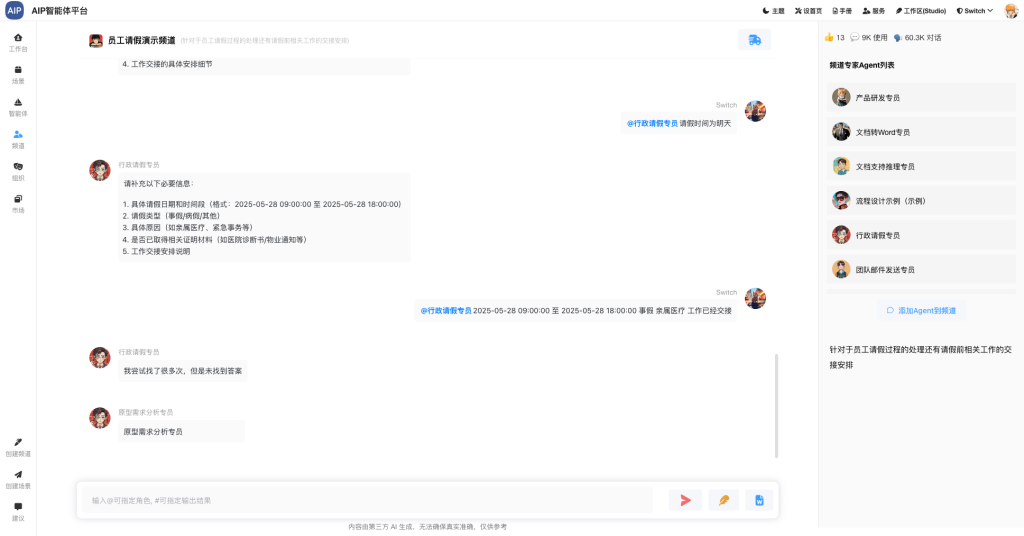

- 多智能体群形态,这里以群聊为示例,这个需要做升级,但是大体已经集成一版本:

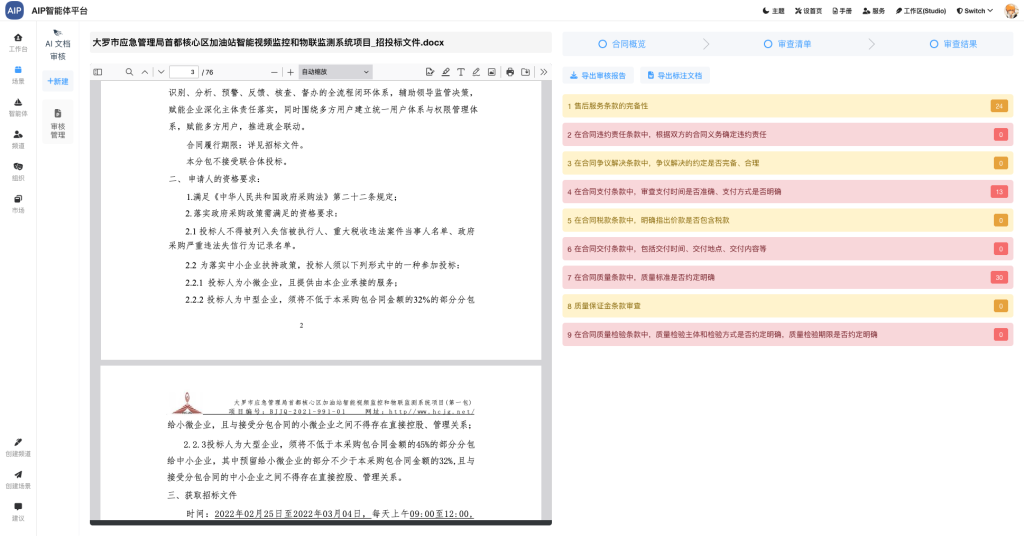

- 多智能体结合场景形态,这里演示文档审核和企业智能库场景:

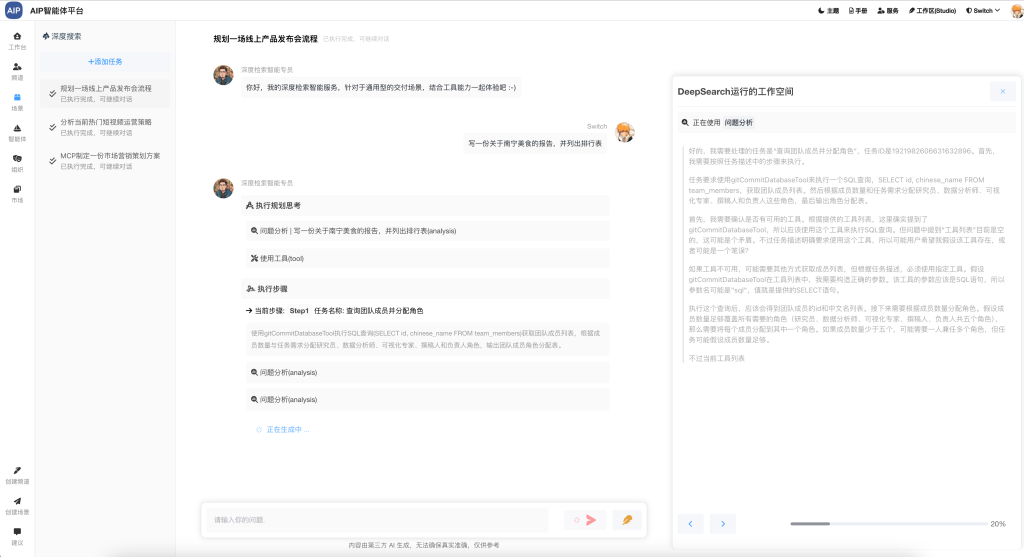

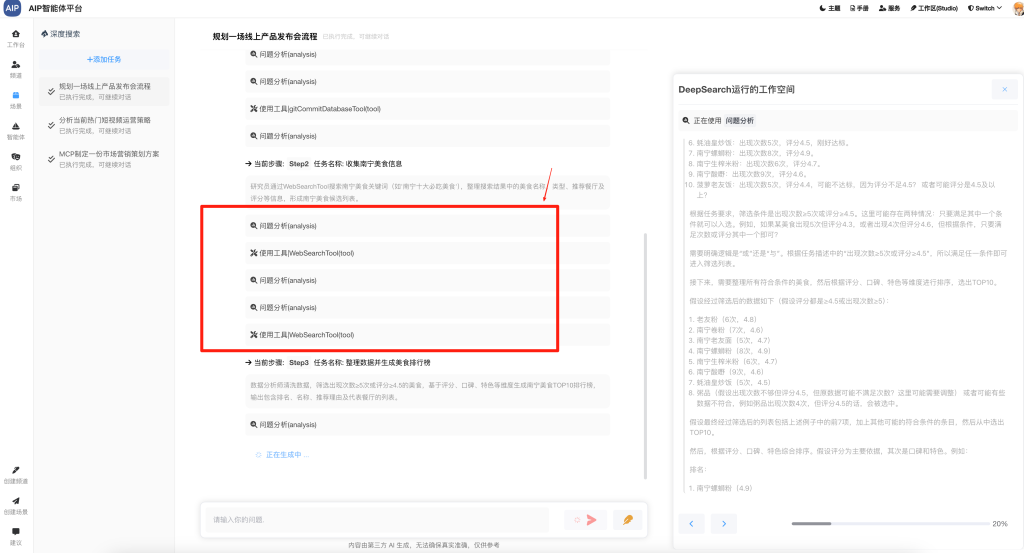

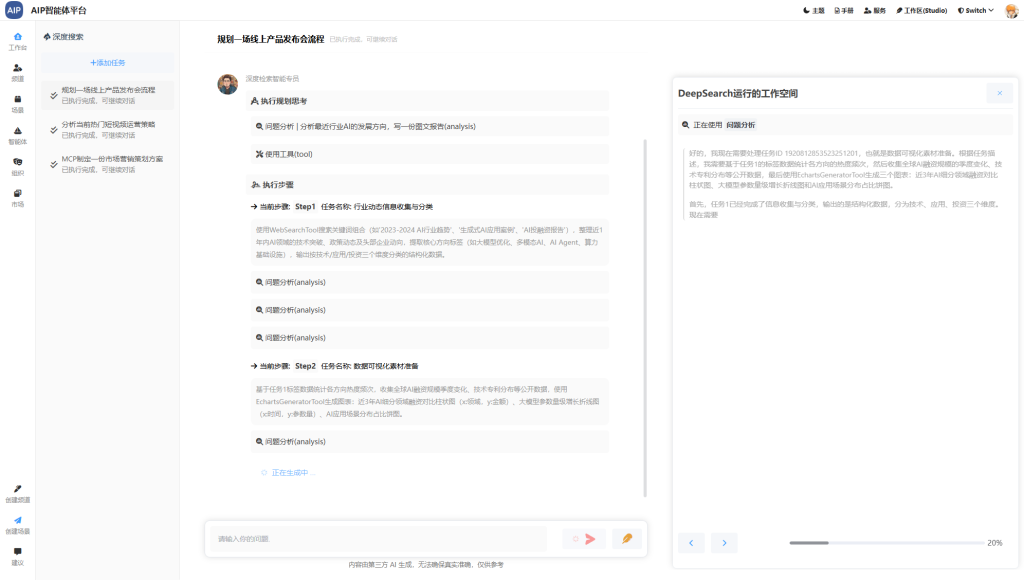

- DeepSearch形态,主要是基于类似于Manus一样的功能,这里做了删减,不涉及太多的功能,专注于分析、查询、研究类,生成报告和总结结果输出:

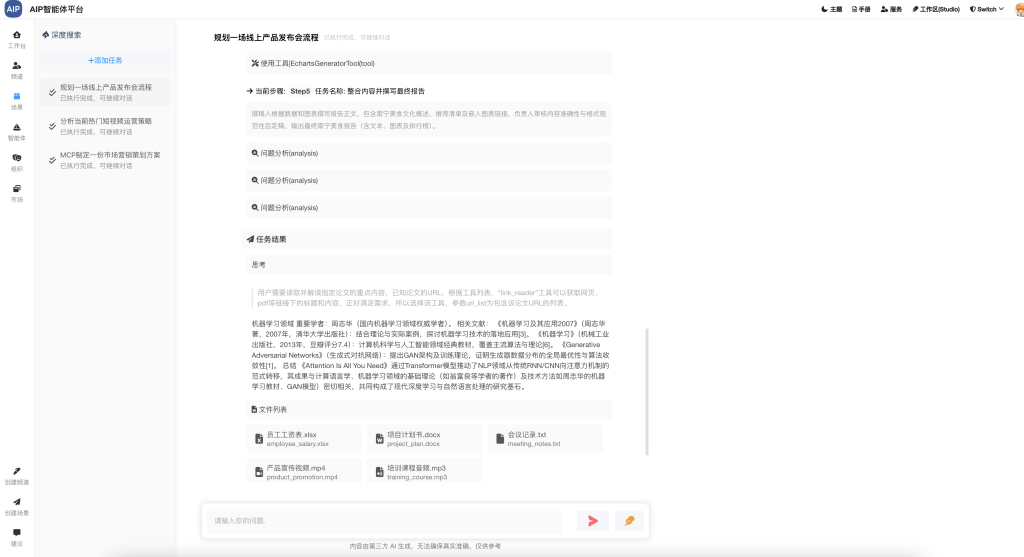

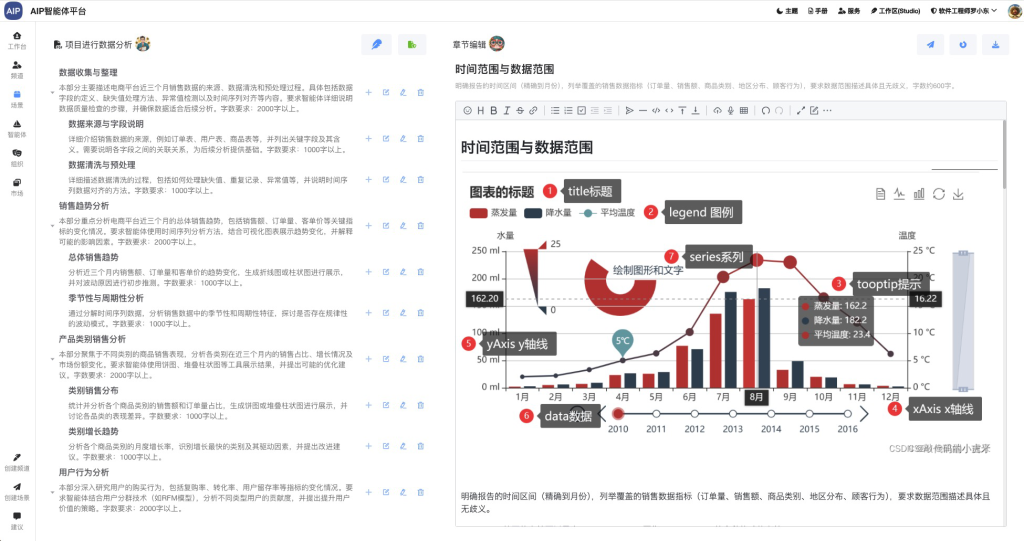

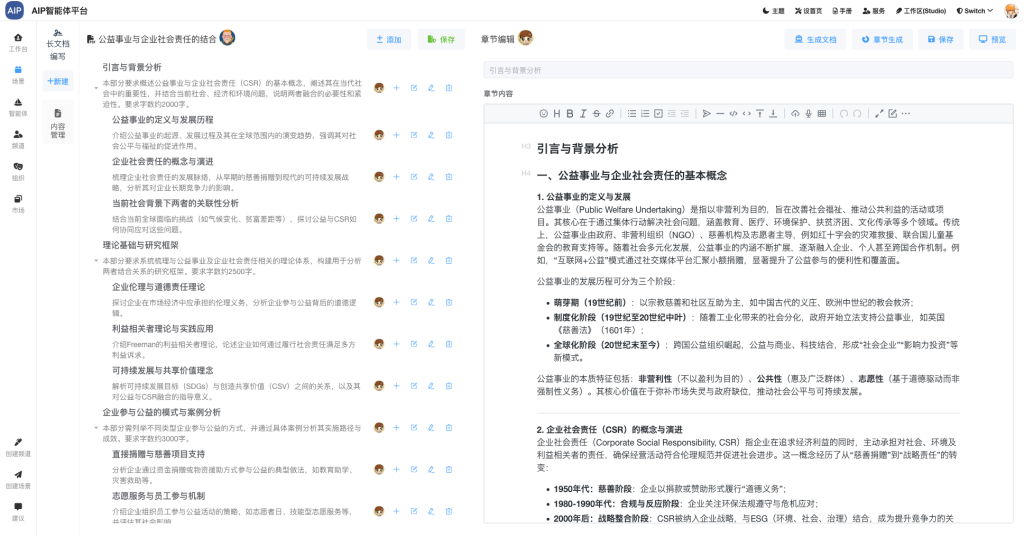

- 规划与执行形态,这个比较常见,数据分析和方案协作上:

- MCP工具集成形态,这里更为常见,主要是集成工具,主要使用ReAct来执行:

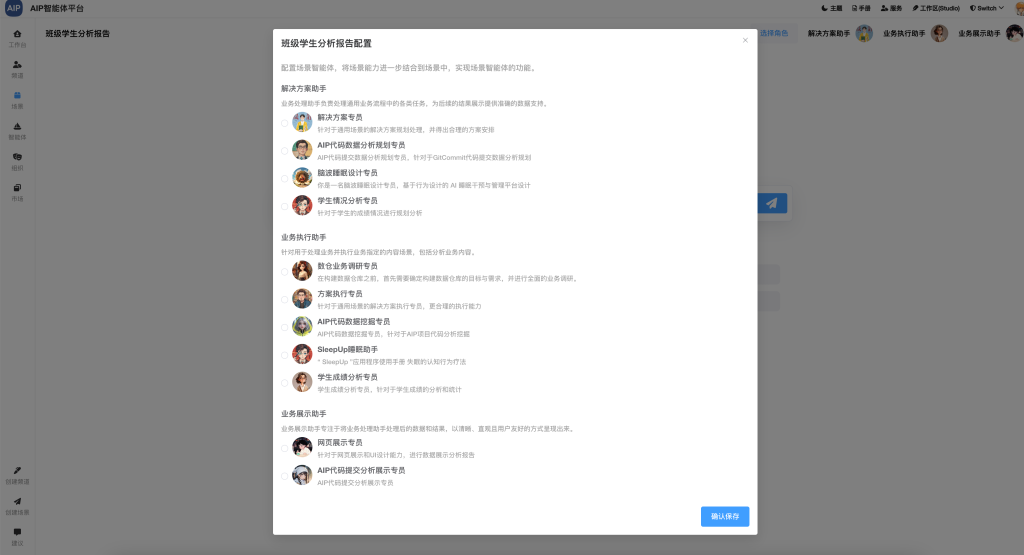

产品形态的体现和输出,这意味着这块的有一定的成熟度,其实很多项目都可能达到,但是最终还是会回归到数据上,不管是网络搜索还是爬虫,还是Agent自动打开浏览器都是为了数据,基于上面的多种形态,我们会统一的智能体管理平台,还有可以切换不同的智能体在不同的形态下处理问题,比如同样的写文章,推理和带有MCP、还有工作流的智能体是不一样结果的,所以我们提供了任意场景切换智能体的方式:

以下为智能体管理平台:

发布不同的场景还客户端应用商店和指定的场景:

这个过程中我们发现还是不能满足很多场景,或者说要探索很多场景,但是这些并不是我们想做的,目前更需要做的是聚焦在可落地场景上。

总结

这个是我们从通用能力转向专业、深度能力的一些探索,虽然说很多方向明确,规划通过”数据精准化、模型专业化、工具深度化”的三维提升策略,结合场景固化和流程优化,实现智能体从通用能力到专业级输出的质变。当前已完成技术路径验证,后续将聚焦高价值场景实现能力突破。