鍵盤事件是 Web 開發中最常用的事件之一,通過對鍵盤事件的捕獲和處理可以提高網站的易用性和交互體驗。下面,我們向大家介紹收集的20款優秀的 JavaScript 鍵盤事件處理庫,幫助開發人員輕鬆處理各種鍵盤事件,趕緊收藏吧!

您可能感興趣的相關文章

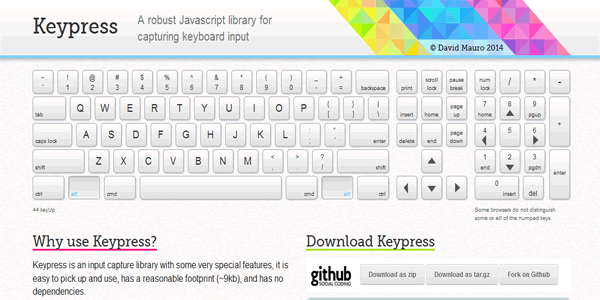

Keypress 是個有着許多特別功能的輸入捕捉庫,它非常容易使用,有個極小的腳本(約9kb),而且沒有任何依賴。這個庫支持所有主流的瀏覽器和操作系統,但是沒在非英文的鍵盤上測試過。

Mousetrap 是個沒有外部依賴的獨立庫,它最小約為 1.9kb,Mousetrap 非常容易擴展,只要頁面中包括 Mousetrap 和需要擴展的 JavaScript 庫就可以了。

Mousetrap支持的瀏覽器有: Internet Explorer 6+, Safari, Firefox 和 Chrome。

jQuery.Hotkeys 允許用户在源代碼中添加或者刪除各種鍵盤事件,幾乎支持任何組合鍵。只需要一行代碼就可以綁定或者解綁快捷鍵。支持(Win/Mac/Linux)平台上 的瀏覽器: IE 6/7/8, FF 1.5/2/3, Opera-9, Safari-3 and Chrome-0.2。

Keymage 是用 JavaScript 實現的極小的處理快捷鍵綁定的庫,它沒有任何的依賴項,非常容易擴展,用户很容易就能使用它開發一個新的庫。

KeyboardJS 是個 JavaScript 庫,用來綁定鍵盤組合鍵,不會有任何的鍵盤代碼和鍵盤組合鍵衝突。它可以作為一個獨立的庫也可以作為一個 AMD 模塊。它支持單一快捷鍵或者組合鍵,可以在任何地方使用。

kbNav 可以很方便的使用鍵盤來進行用户友好的網站導航。kbNav 快捷鍵會出現在用户點擊的對象中。用户可以很方便的找到想要使用的快捷鍵。用户可以使用網站開發一些無意識的快捷鍵和一些行為的關聯,消除記憶快捷鍵和行 為的麻煩。kbNav 只需要點擊相應的鍵盤,按 Enter 就可以生效,而且快捷鍵可以包含字每和數字,用户可以為每個行為都製作相應的快捷鍵。

Keymaster 是個簡單的微型庫,用來定義和分配 web 應用的各種快捷鍵。Keymaster 沒有任何依賴項,可以完全獨立使用。它支持任何的 JavaScript 庫或者是框架。

Keymaster 可以在任何瀏覽器上定義 keyup 和 keydown 事件的快捷鍵。目前支持的瀏覽器有: IE (6+), Safari, Firefox 和 Chrome。

jwerty 是個 JS 庫,允許用户綁定,啟用和定義相關元素和世間的快捷鍵方式。它一般包括一些極小的標準 API ,非常容易使用和清除。它大小約為 1.5kb ,而且沒有任何依賴項,同時又兼容 jQuery,Zepto 或者其他 。

KeyCode.js 是個跨瀏覽器的 JavaScript 常規鍵盤快捷鍵庫。這個庫圍繞鍵盤對象來運行,還有一些 { Int code, bool shift, bool alt, bool ctrl } JavaScript 對象,記錄用户按下的鍵盤對象。translate_event() 方法會返回其中一個對象; hot_key() 獲取其中一個然後返回一個符合 JQuery HotKey 插件或者 Binny V A’s shortcut.js 庫的字符串。

使用這個庫,用户可以添加鍵盤快捷鍵到 JavaScript 應用中,它支持Mac 的 Meta Key,但是目前只是測試版,需要小心使用。

keyboard.backbone.js 依賴於 domEvents.backbone.js,domEvents.backbone.js 又依賴於 jQuery 和 Backbone。keyboard.backbone.js 主要是依賴 domEvents 的 keyDown 和 keyUp(也叫做:key:down 和 key:up),所以如果用户想執行不一樣的 key:press 需要另外一個不同的庫。

Kibo 是個簡單的 JavaScript 庫,用來處理各種鍵盤事件,沒有任何依賴,而且完全開源。

這是個令人印象深刻,而且又容易使用的 JavaScript 快捷鍵庫,可以處理各種鍵盤事件。

UserKeyboardShortcuts 是重構了 mootools-more 提供的鍵盤類,提供給用户本地自定義的鍵盤快捷鍵,不需要用户做過多的操作。

用 户只需要用 Keyboard.addShortcuts ( Keyboard.Extras提供的 )來改變他們的快捷鍵。UserKeyboardShortcuts 使用 localStorage (對 cookie 失效)來存儲用户所做的修改,當頁面重新加載的時候恢復原狀。

okShortcut 包括兩個方法: jQuery.shortcut.add 和 jQuery.shortcut.remove ,分別用來添加和刪除快捷鍵綁定。兩者都可以綁定組合鍵和進行回調。 jQuery.shortcut.add 可以選擇接收一個選項 hash。

jQuery Beeline

Beeline 是用最直接的方式去綁定快捷鍵,為 Web 應用提供鍵盤導航。它是基於 jQuery Hotkeys.。

jQuery Shortcuts 是個超輕量級的方法,使用 jQuery 來綁定快捷鍵(熱鍵)。

key-board-short-cuts 是用 JavaScript 實現的簡單鍵盤快捷鍵示例,它不是一個複雜的 JavaScript 綁定事件。綁定快捷鍵之後所有的行為都需要開發者自己去自定義。

jKey 是另一個非常有用的 JavaScript 快捷鍵庫,用來處理鍵盤事件。它使用 jQuery,所以可以選擇任何可用的元素來設置快捷鍵命令。基本上,任何元素,比如一個輸入框或者文本框,都會有一款適用的快捷鍵命令。

Keys.js 是個卓越的瀏覽器應用快捷鍵綁定工具,它可以使用 localStorage 來進行串行化持久性綁定,或者上傳到服務器中,對用户的 Web 應用進行個性化設置。使用相同的 API 就可以很方便的反串行化。

Key.js 擁有 CommonJS 和 AMD 模塊的支持,可以跟 require.js 或者其他模塊加載器一起使用,目前支持的瀏覽器有: IE7+, Firefox 21+, Safari 6+ and Chrome 27+。

欣賞完這麼多方便又驚豔的鍵盤事件處理工具,跟大家分享一下你的感受吧:)