软件工程师罗小东,技术架构师,有一些平台化和产品化经验,目前在结合新技术研究平台中

概述

一直以来都是接触平台技术,主要集中在中小企业上,从平台化、中台化、产品化几个路线都有一些的实践、运营和落地点,但是问题也随之而来,另外随着行业AI技术的发展,新的平台形态是怎么样子,这个也在思考和探索。本次分享主要是结合企业平台化和AIGC结合上的经验分享,同时我们对平台下一步的形态方向。

通过集成超自动化的理念,使用平台自动驾驶仪操作模式进行管理。能在不干涉的情况下生成优化平台。结合了AIGC的推理能力,使平台管理更加自动化和智能化,结合实践过程中的指导和管理的最佳实践。

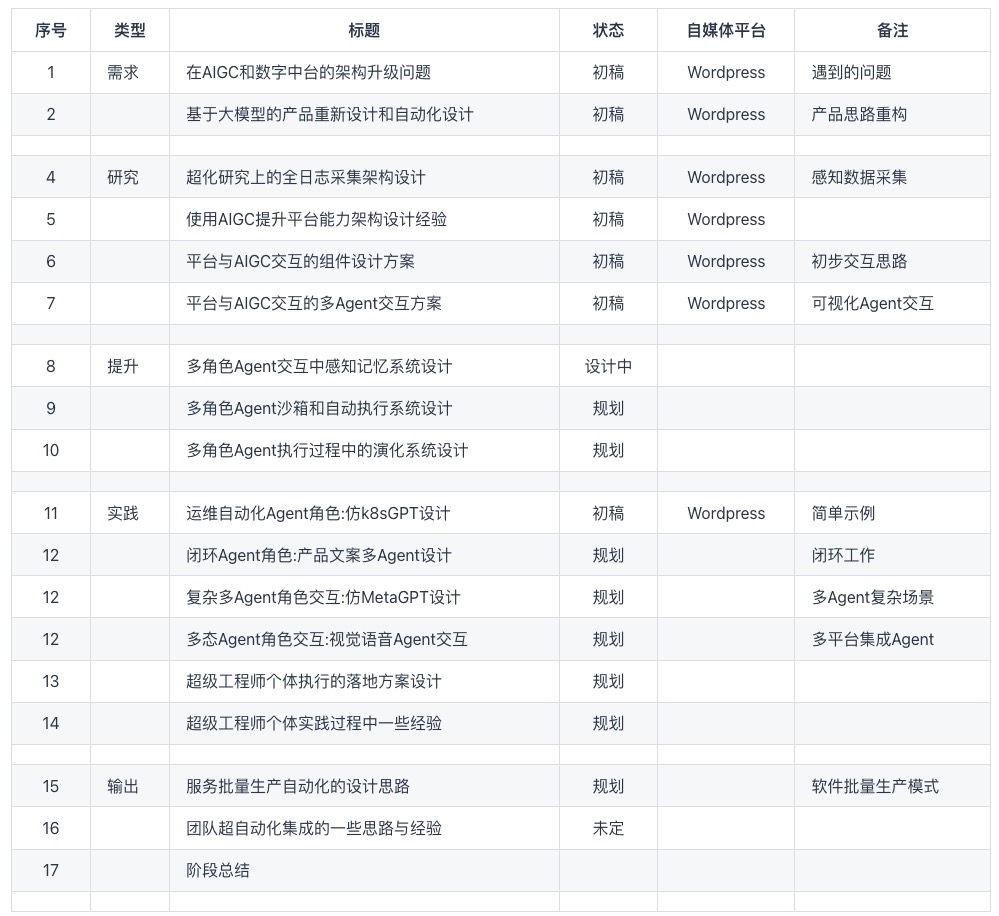

这里分享主要从几个平台形态维度来进行阐述,大致内容如下:

1、中小企业目前平台化的产品形态

2、平台在项目落地常见的处理方式

3、平台超自动化和AIGC的结合方案

4、后期的愿景和应用自动化赋能

每个设计人员有自己的方案和思路,有不同的路径,我有我思,期望可以给一些不同的参考。

这里是分享稿,会略带口语化,同时偏向于中小企业偏多的场景,比如研发团队规模在几个或是几百多研发团队的场景。

内容阐述

这里按我们提的几个点来阐述,结合实际和开源项目来进一步实践阐述,一个是吸引这方面有兴趣的朋友,另一个是降低研发成本,提高软件质量。

中小企业目前平台化的产品形态

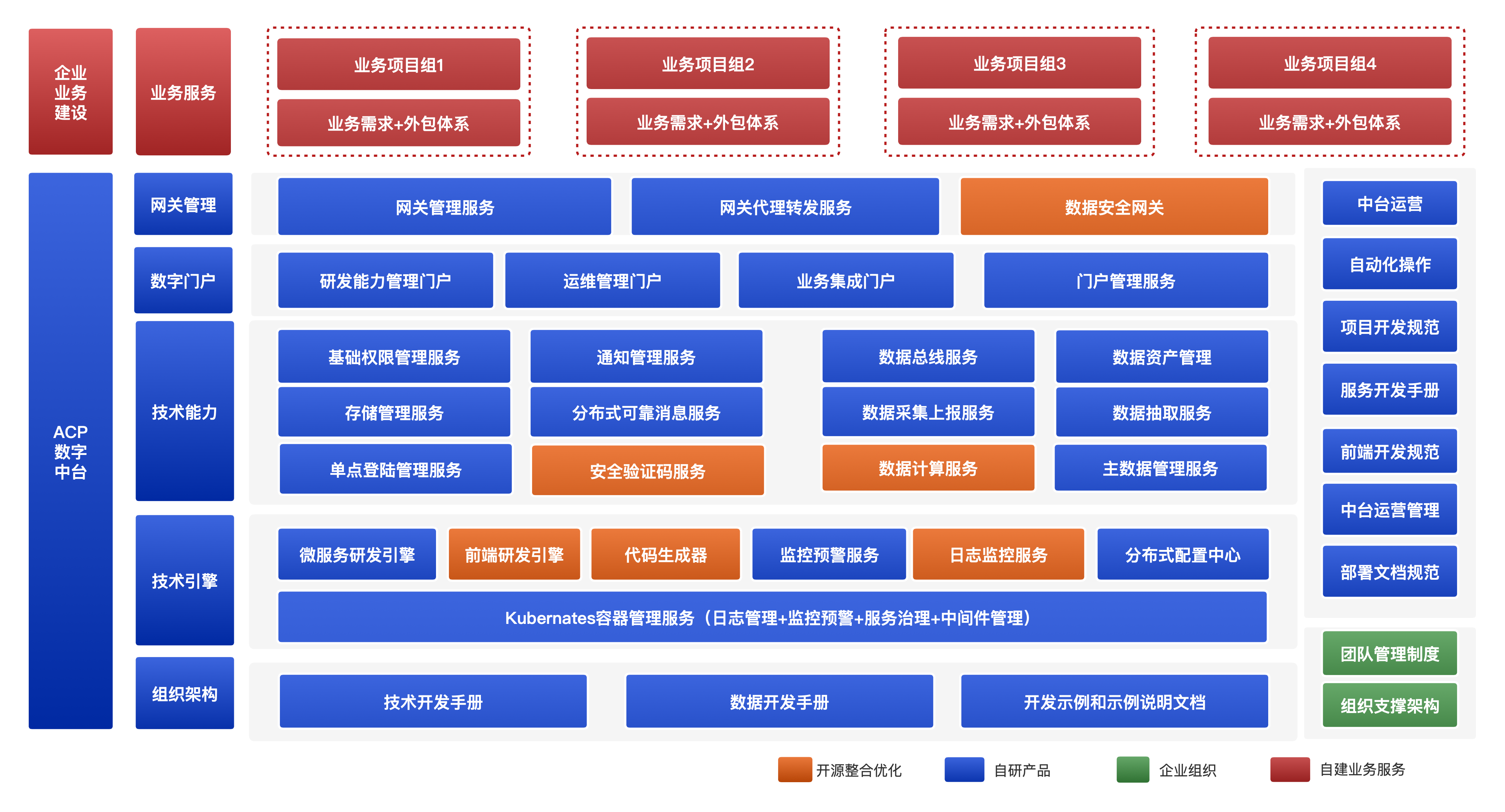

首先我们先来了解目前多见到的企业平台化内容,就是通用常见的层面。

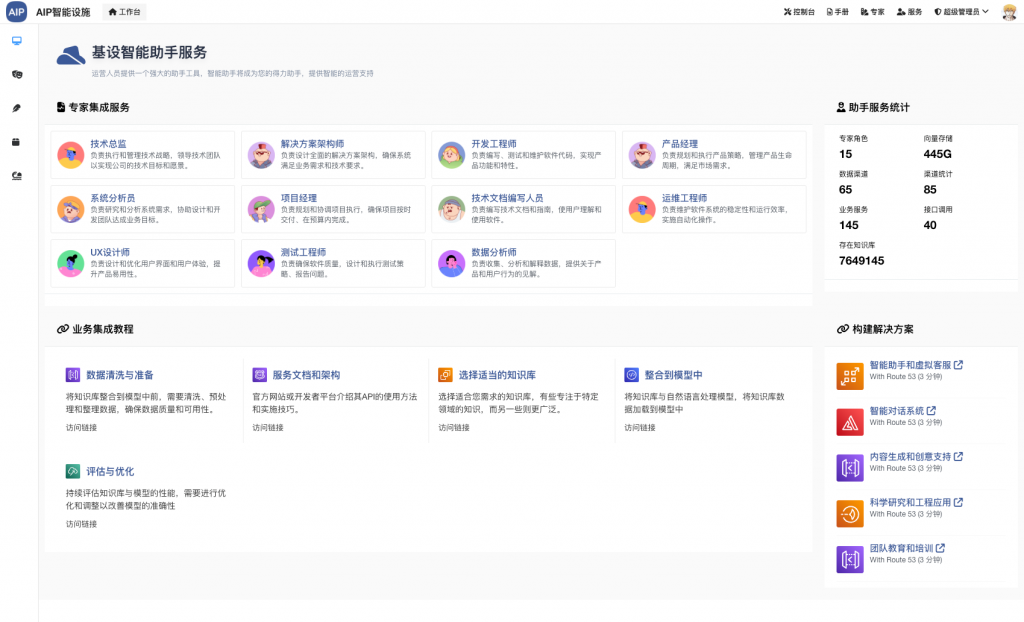

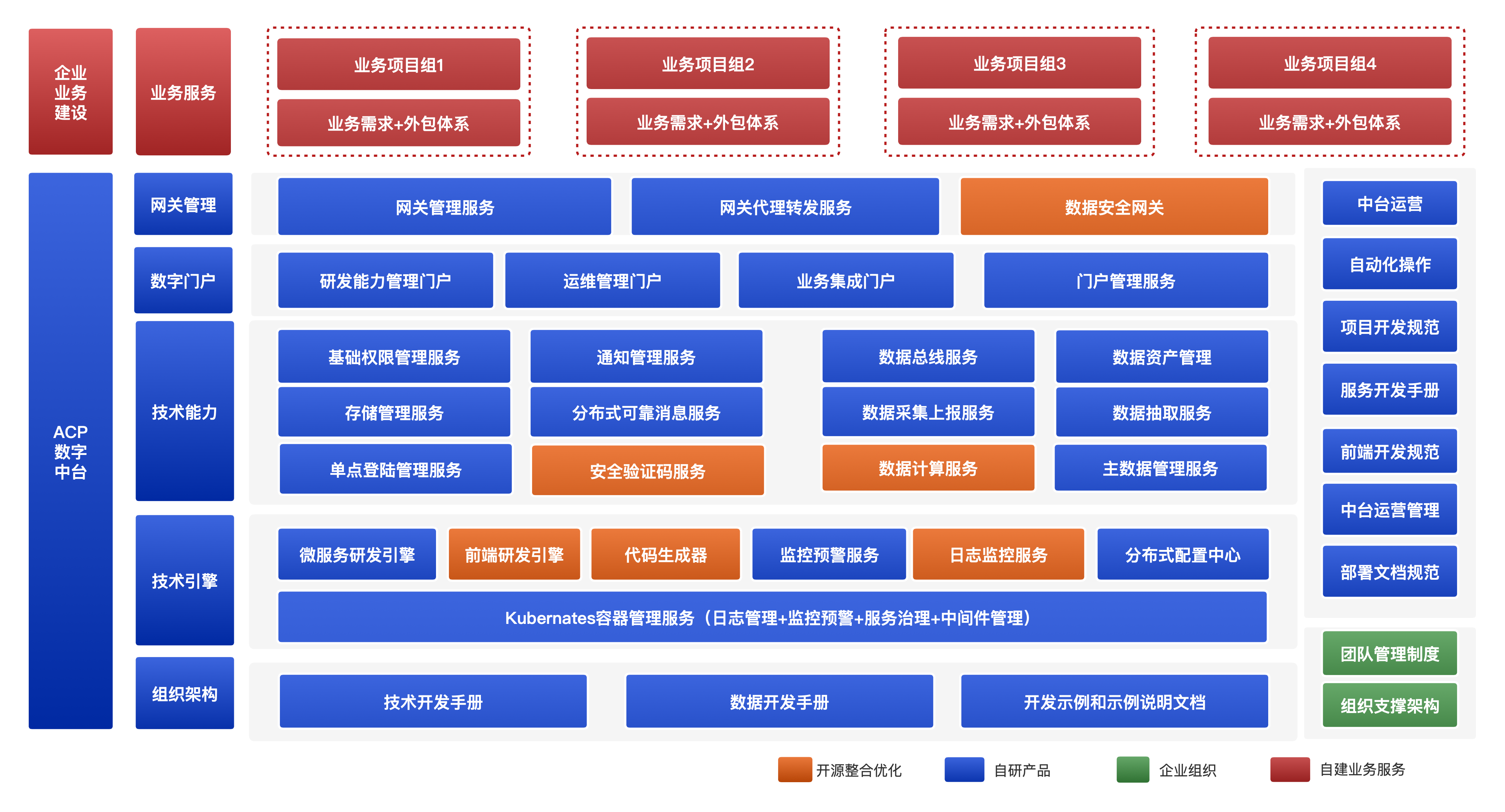

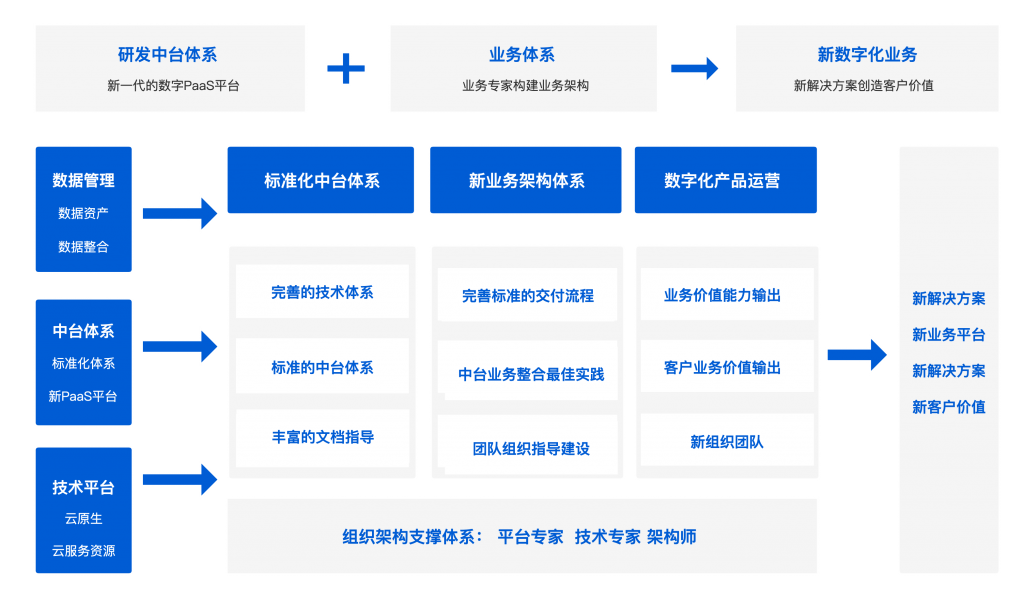

一般来说,企业研发型平台主要包含有基本的devops、通用开发平台、快速开发平台、数据治理平台、AI平台、还有一套运维管理体系,后面做得发展产品形态的,可能还有一套运营管理平台,可能是saas化或单独项目化,这个主要看团队。

目前这些基本上都很多形成很多企业或是团队的配置点,形成一套基础的环境在项目或是团队。

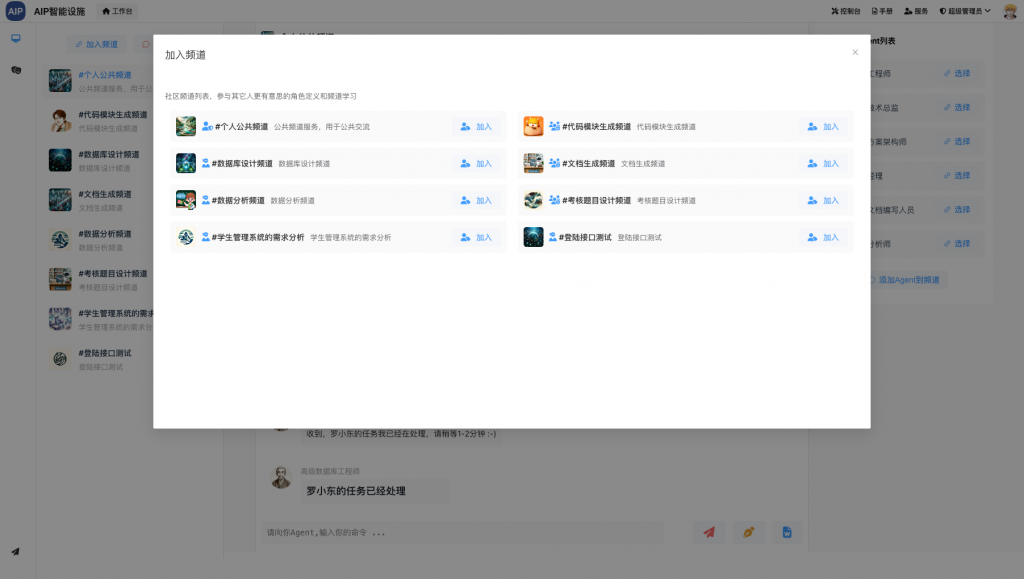

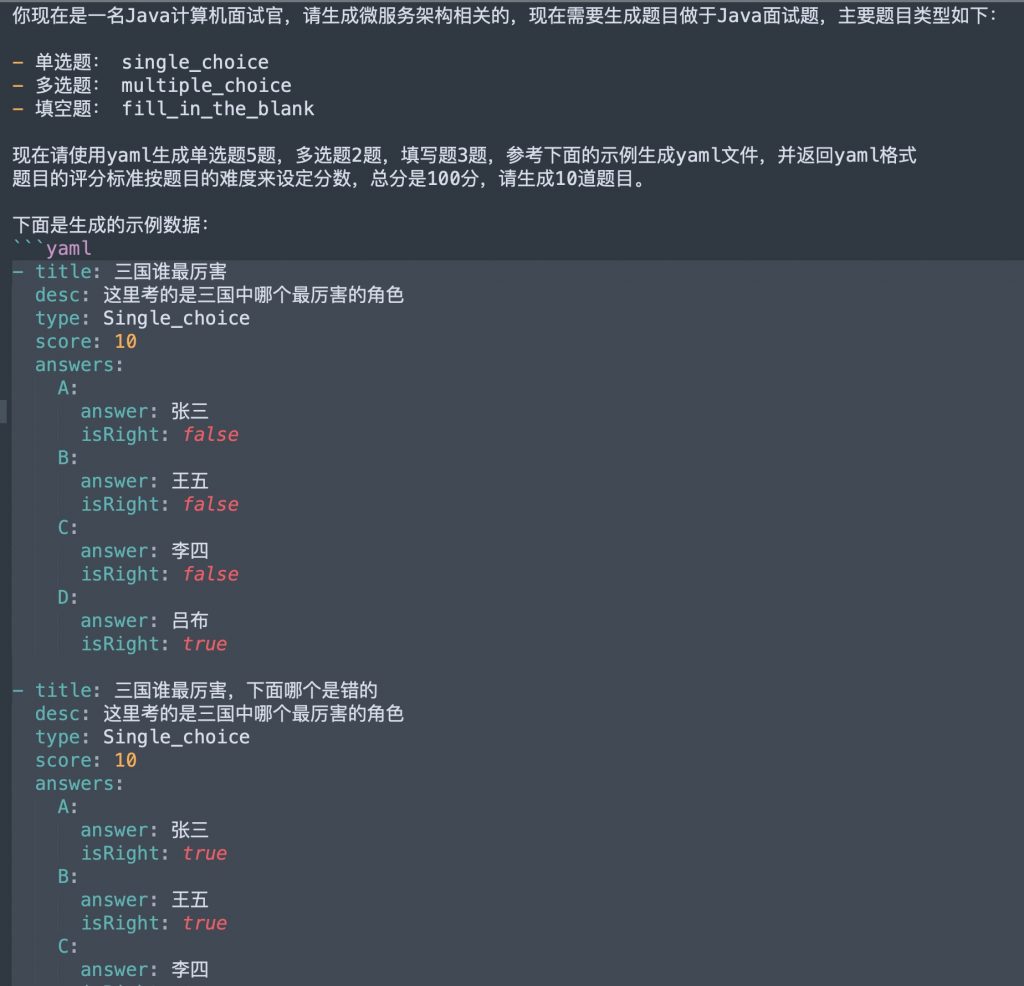

这里我们为了更好的研究,我们这里也利用开源技术搭建了一个简版的企业平台,主要是结合Ops体系连接起来,比如devops/dataops/chatops/aiops等,同步搭建一个运营平台,用于管理,同时对外提供SaaS租户能力。

平台在项目落地常见的处理方式

假如说,我们把一个平台比作一个膄船舶,这个对很多中小型团队来说,这可能就是一个中等级别的航母,打造一个航母在一定的经验和资金存在的情况下,可能并不是特别难,但是运营管理上,成本可能就出来。一次出行,需要配置的人员、资源、还有发挥的能力等都是消耗极大的,再加上后期升级、维护管理等都是一比不小的开支。

这里主要是过程中常见的几个点:

- 各种平台技术概念的灌输

- 团队人员的培训流程化

- 完善的平台文档和培训

- 各种流程制定和标准文档

- 过程人员项目技术支持

- 脚本过程的自动化

- 运维管理的自动化

- 项目和代码生成的自动化

- 测试脚本和自动化

- 服务器监控处理的自动化

- ……

比如以下几个例子:

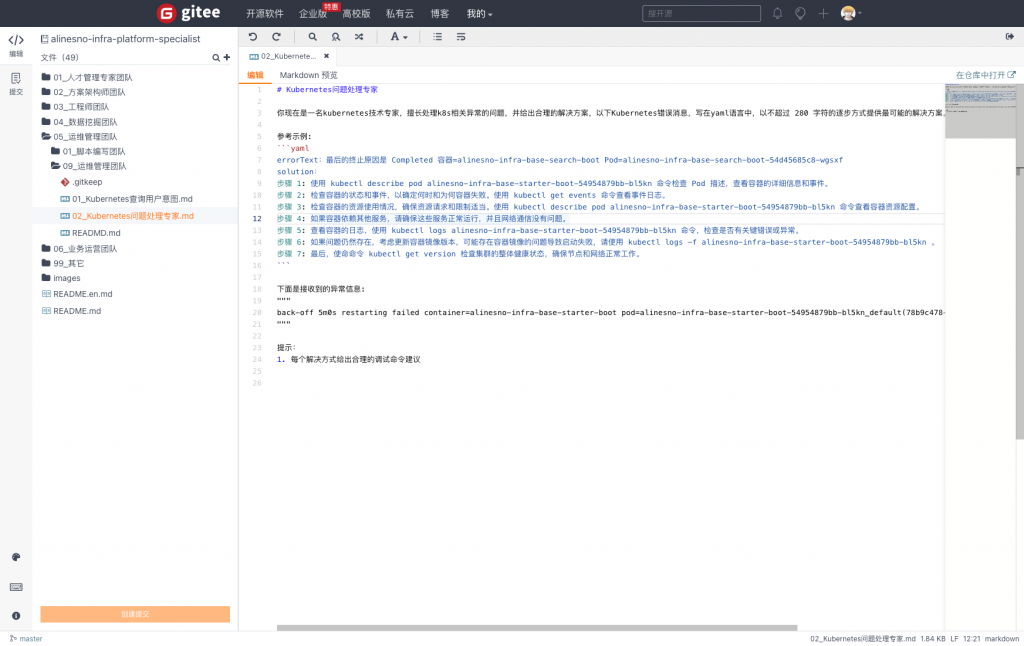

过程的管理使用自动化的脚本和多种自动化的能力,来实现多个服务和多个组件之间的维护管理,比如运维和自动化,包括运维的自动化、发布的自动化、还有数据采集的自动化,同时结合钉钉进行统一的进行交互,达到一个ChatOps体系的目标。

另一个是人员的培养,也做了很多文档和经验分享,包括人员入职还有每周会进去考核,整理出经验,每隔一段时间进行一次内部的沙龙分享,以达到对平台技术的熟悉,还有项目使用过程的熟悉。

当然,还有很多,你会发现这个过程需要东西,很多都形成标准和自动化,但是针对于中小型企业来说,要落地,同时也发现另外的问题,比如人员要求过高,架构师支持,技术要求高,还有流程过多,复杂,整体结合串起来需要较大量的知识面等,特别是整个平台过程管理需要大量的实战经验。

这个问题导致的一个最大卡点,是平台的延续性的问题,这个针对于中小型企业来说,几乎是致命的。我们换个角度来考虑,在人才还有资源,投入有限的情况下,一旦说有一部分跟不上或者说无法偏差,很可能这个平台就会变得维护成本极高,使用成本也极高。

比如前端需要架构师,开发需要架构师,数据需要架构师,运维需要架构师,AI算法工程师 … 仅仅这几个岗位角色加起来研发的预算就立马上来。

平台超自动化和AIGC的结合方案

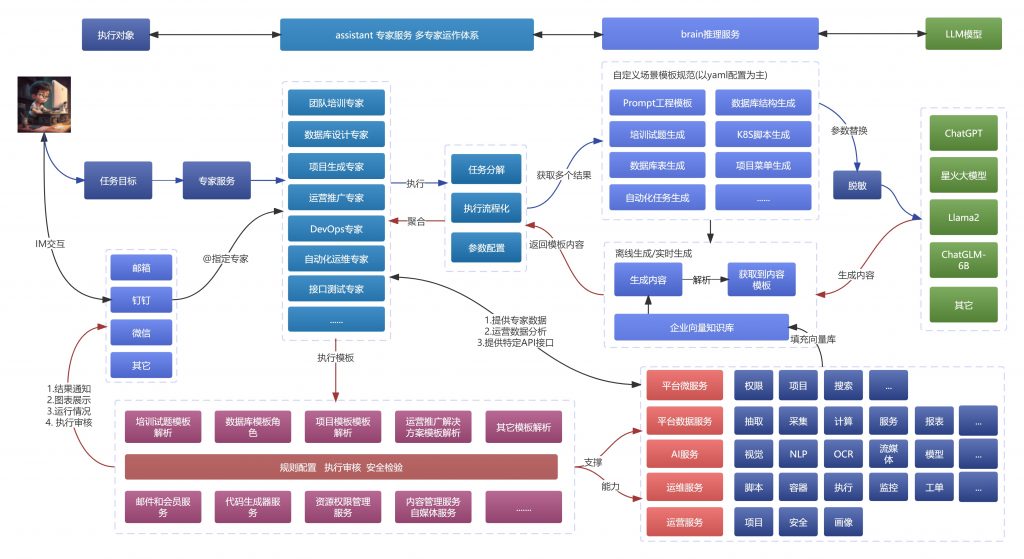

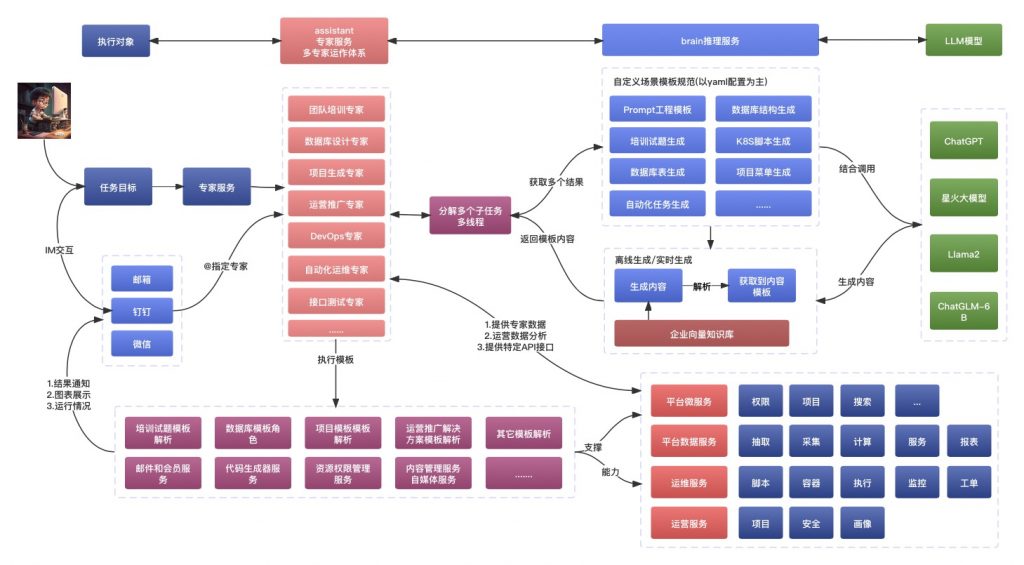

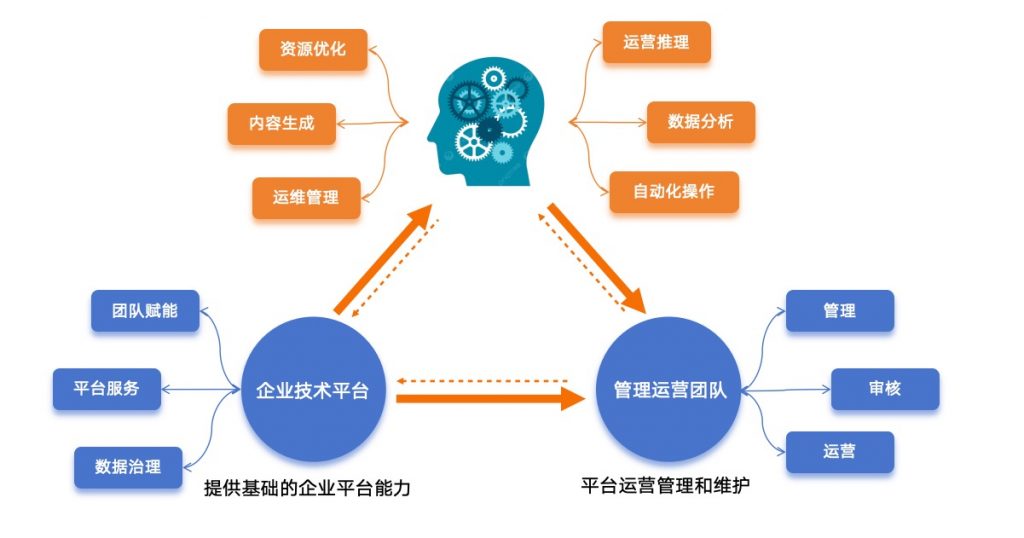

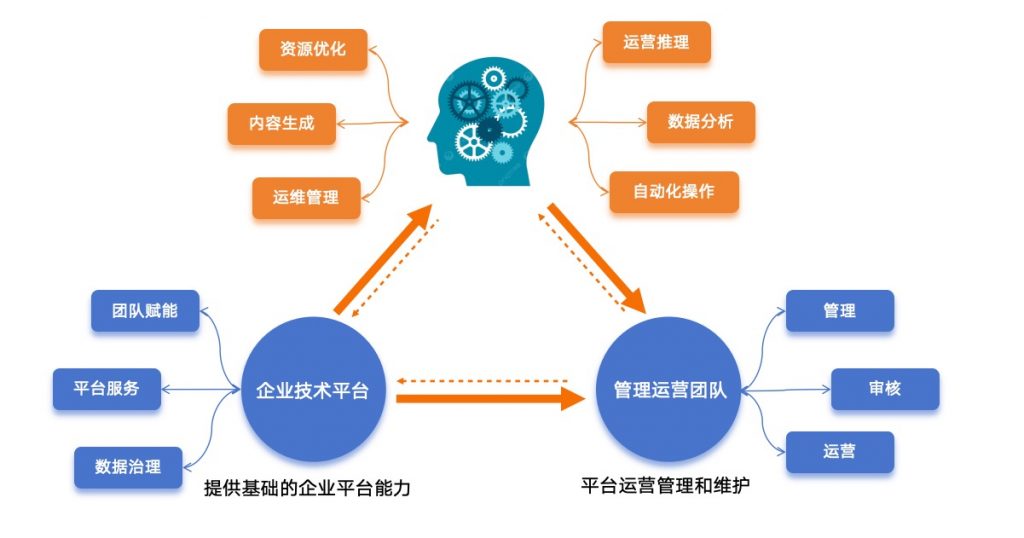

针对于这块上,我们目前整理的解决方案是,在自动化能力上,进一步形成和加强形成超自动化理念的整合,同时结合AIGC一起,进行交互输出,形成更为智能的平台运营方式。

举个简单的例子,假如我们把平台比作一台车,以前的车都是人手工操作的,这个是人工驾驶,而现在的车,可以实现自动驾驶,或者辅助驾驶。那换成平台,也是一样的概念,平台的发展,也应该可以可以实现自动化操作的辅助,形成更加智能化。以前的平台可能是在那里是人工去操作,而更加先进的平台,应该是可以自动去操作,或者辅助操作,以规避掉其使用的复杂性。

再接着上面提到的平台落地过程中的几个点:

- 各种平台技术概念的输出,是否是可以自动结合平台输出给开发

- 团队人员的培训,考核,是否是可以针对要求内容自动生成试题,自动考核结果

- 平台的文档,代码的文档,是否是可以自动的生成解释,形成研发参考

- 过程的自动化脚本,是否可以针对于平台自动生成,同时自动执行

- 项目的解决方案,是否是可以自动生成针对性的解决方案,给市场参考

- 市场商务的推广,是否可以针对平台自动生成,自动投放到媒体平台

- ……

然后这个过程会发现,很多可以基于自动能力上更加智能一层,而在前期的AIGC探索和技术预研中,是可以做到大部分的,特别是大模型的结合,重点是Prompt的定义和数据的输入。这个的理解就类似于,原来的平台可能是人工在操作,但是缺少一个”大脑”在推进和促进它自动发展,让它活起来,或者说”活”得更会思考一些。

这个便是我们提到的,平台超自动化提升,使用平台自动驾驶仪操作模式进行管理。自动驾驶仪操作模式使该平台可以管理项目和软件的底层基础设施,能在不干涉的情况下生成优化平台。根据多年的平台研发和产品化经验,运用经过实践检验和强化的最佳实践来管理和维护平台,特别是优化在最低级别的场景方面。这些工作有助于保护平台,提高基础平台的稳定性和可控性。结合了AIGC的推理能力,使平台管理更加自动化和智能化,结合实践过程中的指导和管理的最佳实践。

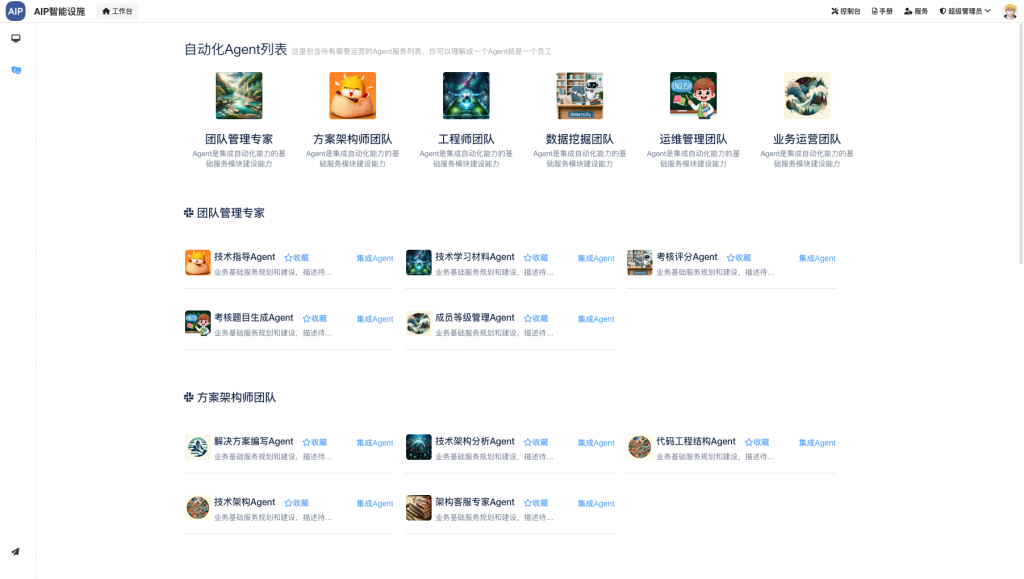

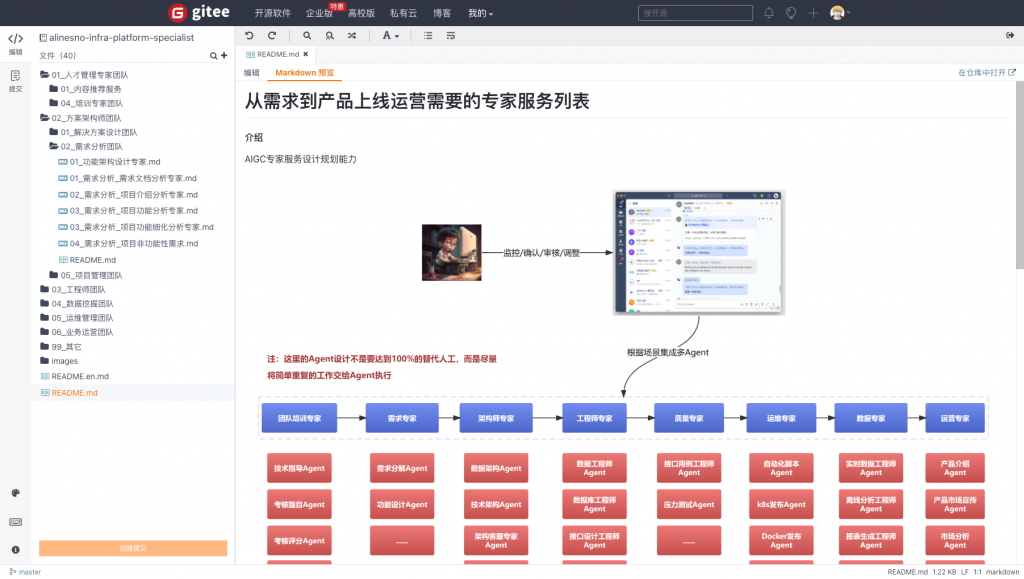

下面是在这块上,我们目前在调试和结合AIGC能力的是几个自动化流程:

- 结合个人成长愿景,技术概念的自动生成和推送

- 团队培养试题生成和考核调度,通过结果形成团队梯队

- 团队知识库和软件工程项目管理文档的自动生成

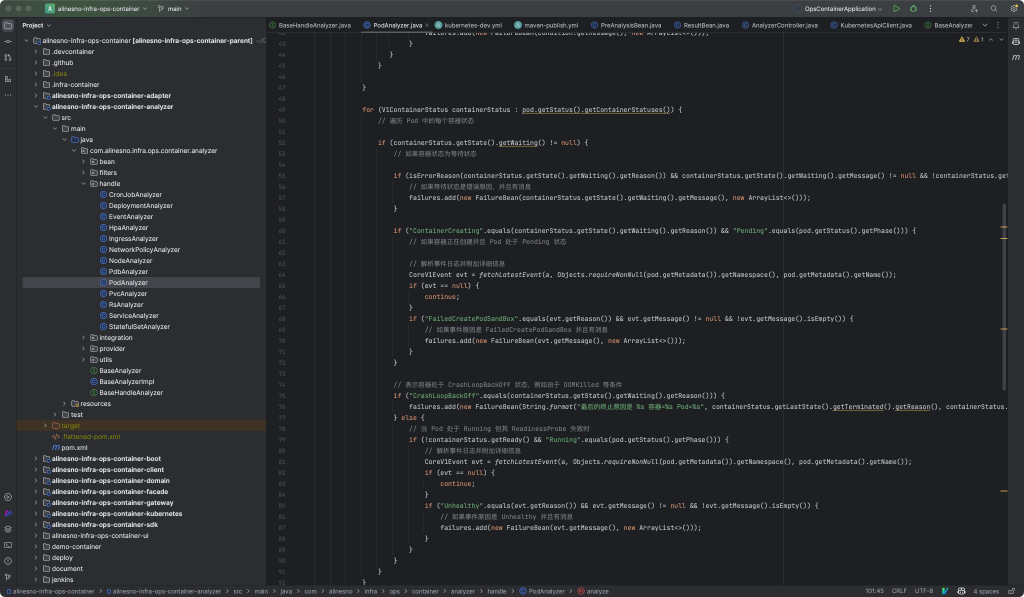

- 开发微服务自动生成和功能自动生成,安全报告生成

- 实时和离线数据方案论,数据指标自动生成

- 资源管理的运维脚本和k8s部署脚本等自动生成

- ……

当然,这些的前提是数据的采集和二次加工,结合Prompt整合起来,为了更好的管理这些Prompt,我们也是建立了一个管理平台,同时结合最新的大模型能力,这样便于我们更好的推进和管理工程结构,我们在某个角度上是期望后面通过不断的调试Prompt和优化数据采集来优化这个流程。

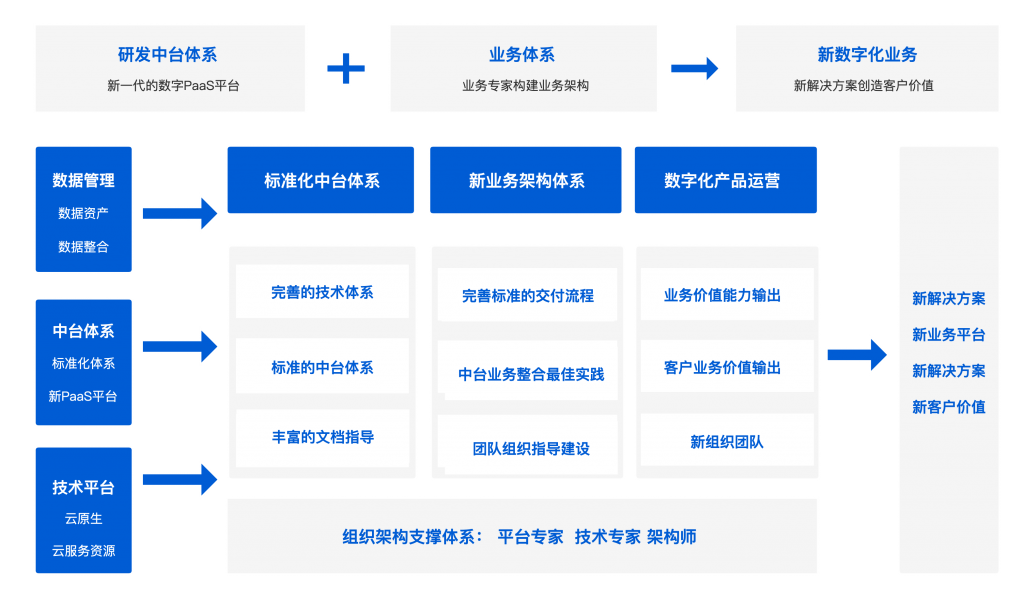

后期的愿景和业务自动化赋能

当前技术的发展有点超过我们的预期,前期平台产化的时候,原来的猜想可能会先走数字化,AI智能的发展还需要几年才可以普及。这也无形中形成一种推进,所以推进平台超自动化理念和形成平台自动驾驶这个计划也提前了进程。

目前的期望是在这块上的研究和处理,能达到基础平台的自动化能力达到预期,后期可以应用到业务自动化的能力上,当然,这个过程为了稳定性和健壮性会有取舍,但是传统的操作在高质量发展要求上,我们预计始终会有一定的提升,如何提升也是我们在探索和挖掘场景。

总结

一直以来接触的都是平台化,中台化等理念,在形成产品化运营之后,在思考如何更进一步的提升,同时结合团队和企业的发展,行业的技术先进性推动基础平台更加的智能化,使用平台自动驾驶仪操作模式进行管理是我们在推进的一个方向,当然我们也已经看到很多产品已经在往这个方向的结合。

以上为个人在实际过程中的一些经验分享,每个设计人员有每个不一样的思路,期望可以给其它人员一些参考。