软件工程师罗小东,多年架构和平台产品设计经验,目前在研究平台产品与新技术结合中。

背景

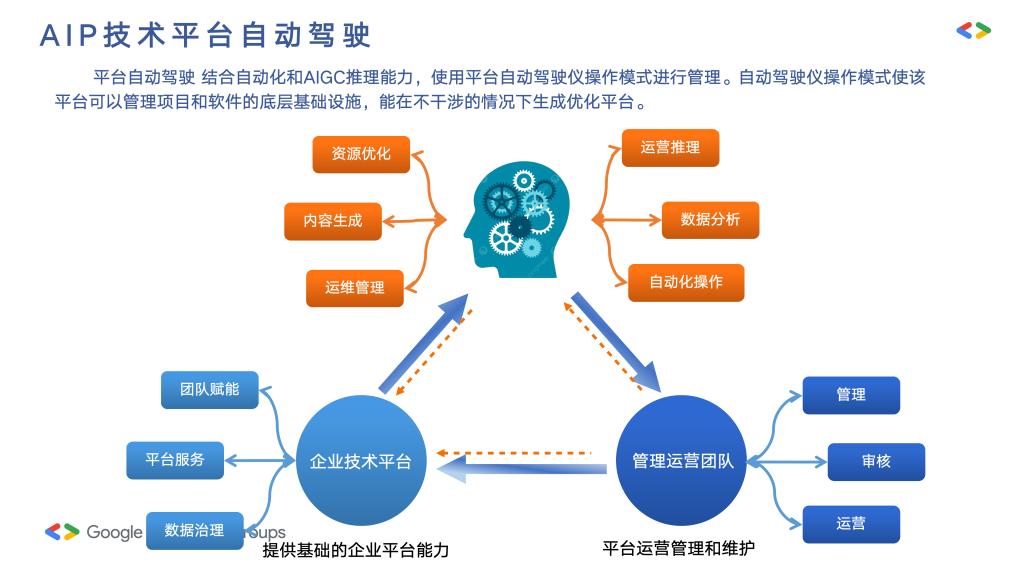

智能体平台是从原来的研发平台,再到超自动化平台演化而来的,在新产品升级设计超自动化过程中,结合LLM技术而进而定位。

阐述主要是给对应的合作伙伴更加的了解AIP产品的使用场景,新来的团队成员更加清楚这个是做什么的。

概述

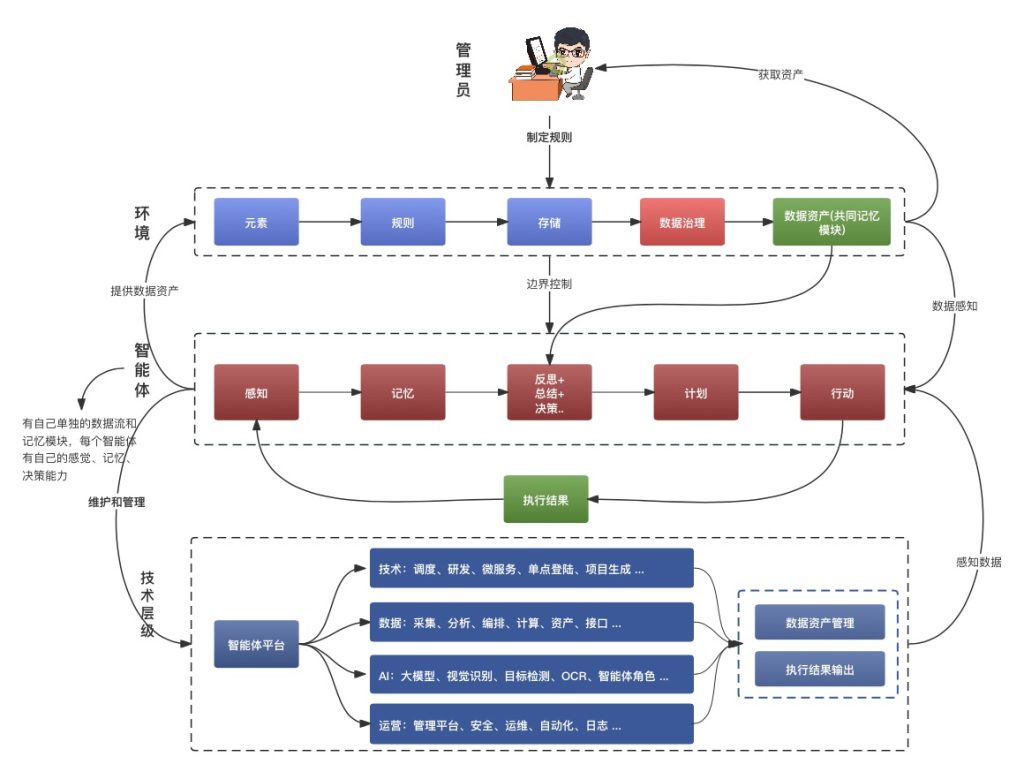

智能体让原来的平台进行自动的演化成长,基础能力包括以下部分:

- 感知能力:通过传感器或其他方式获取环境信息。

- 决策能力:基于获取的信息和内置算法进行决策。

- 行动能力:根据决策结果采取相应行动。

- 学习能力:从经验中学习,不断优化自身的行为策略。

- 适应性:能够适应环境变化,调整自己的行为模式

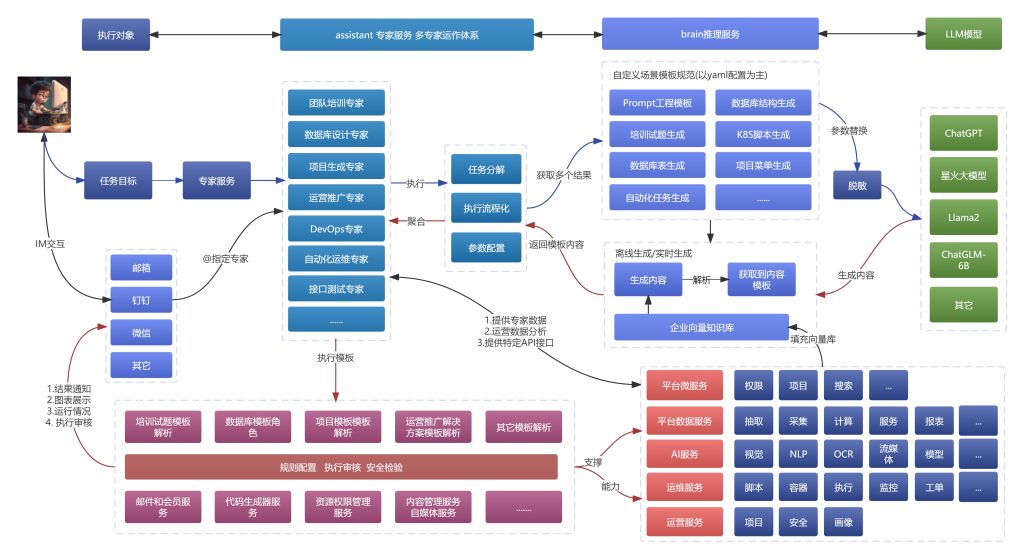

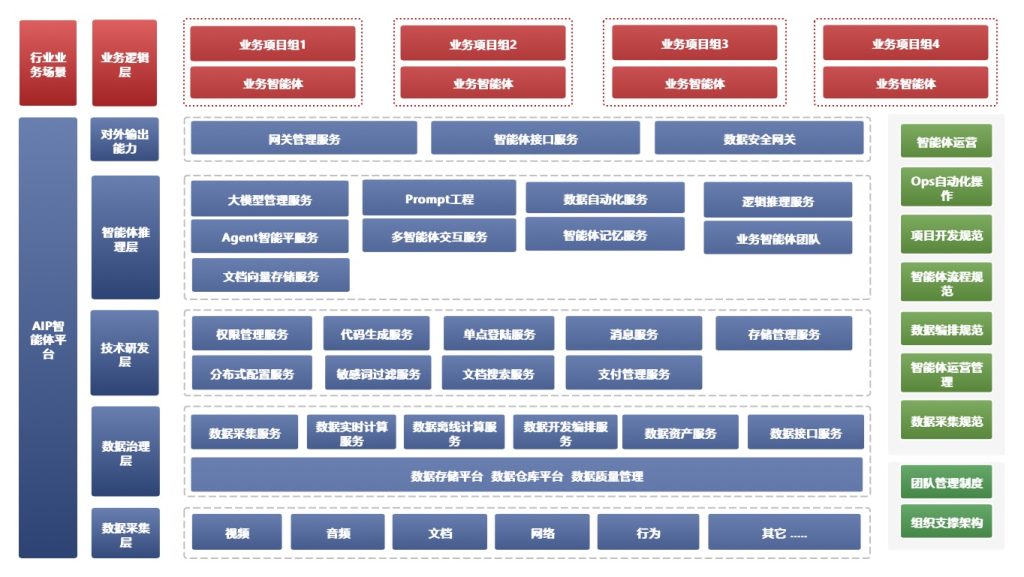

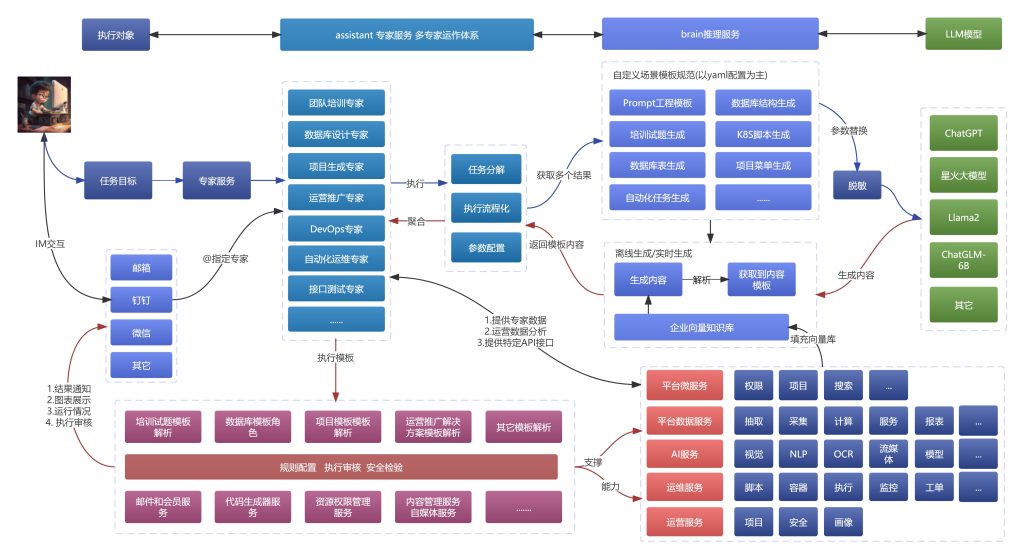

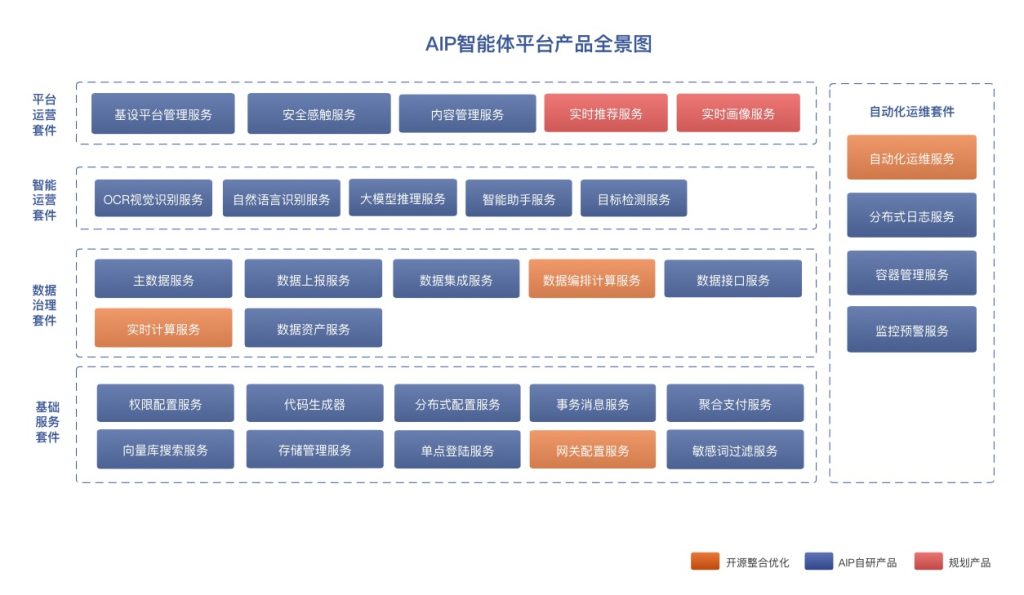

新的智能体思路相近,为了更加明确和定位,进而形成智能体平台方向发展。以下为智能体平台的整体产品架构:

这里结合了平台思想、数据治理、技术研发、自动化运维等一系统平台结合起来。

针对场景和愿景

主要定位还是在中小微型团队,中小微团队情况比较多的是有开发能力和商务能力,给团队提供基础平台建设、架构设计和解决方案能力,以提升市场竞争能力。

业务上赋能上层业务智能体化,可结合业务定制化多种场景的智能体,在原来的业务智能化,提升业务的服务能力。

智能体平台产品设计

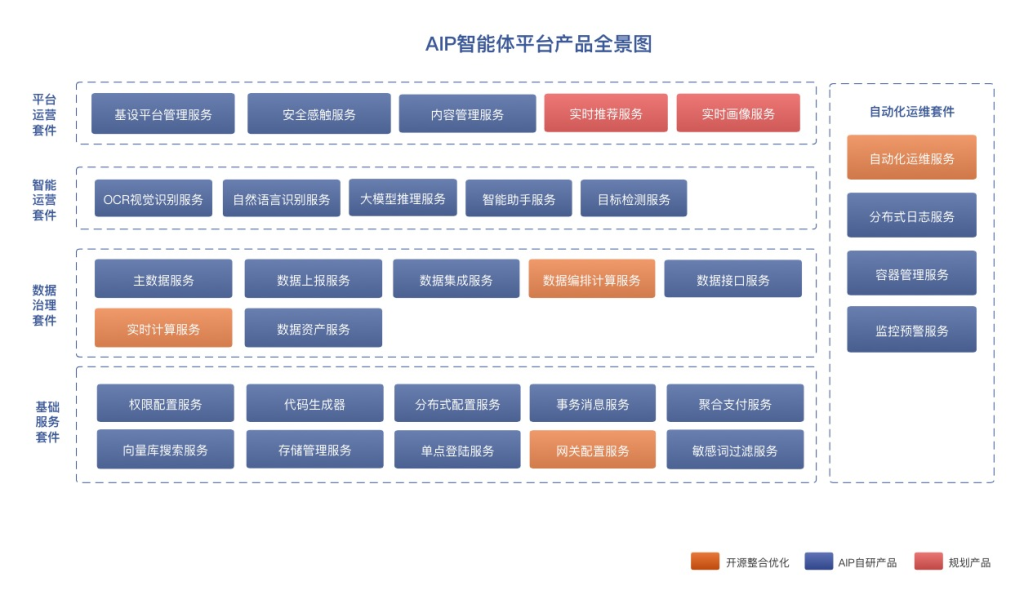

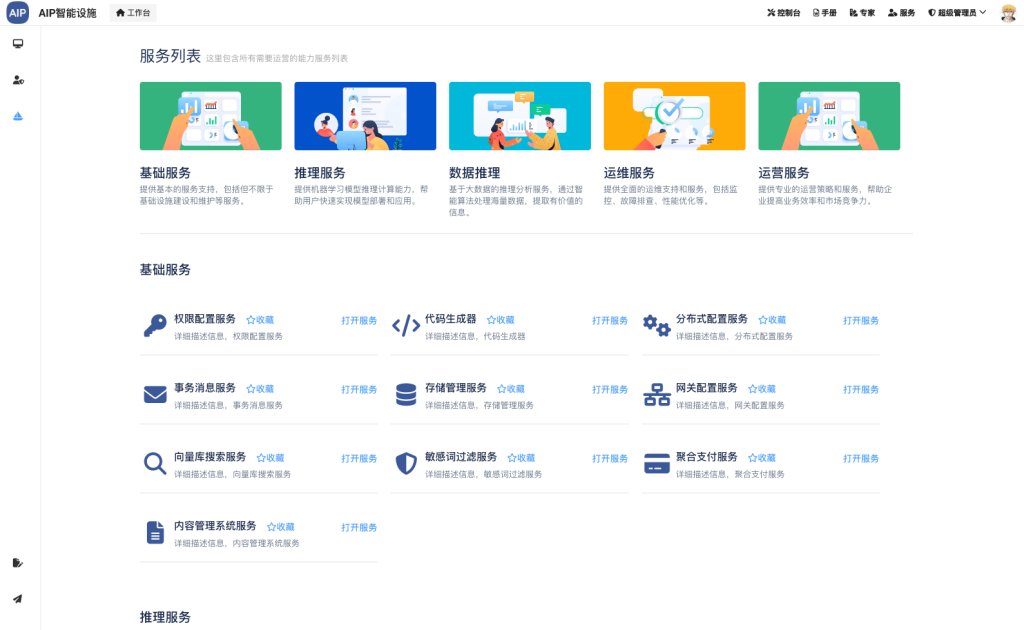

产品设计主要包括几大模块,用于不同的场景使用:

- 智能体平台

- 智能体交互

- 管理平台

- 技术底座平台

- 开发平台

- 数据治理

- 运维管理

- AI平台

- 运营管理

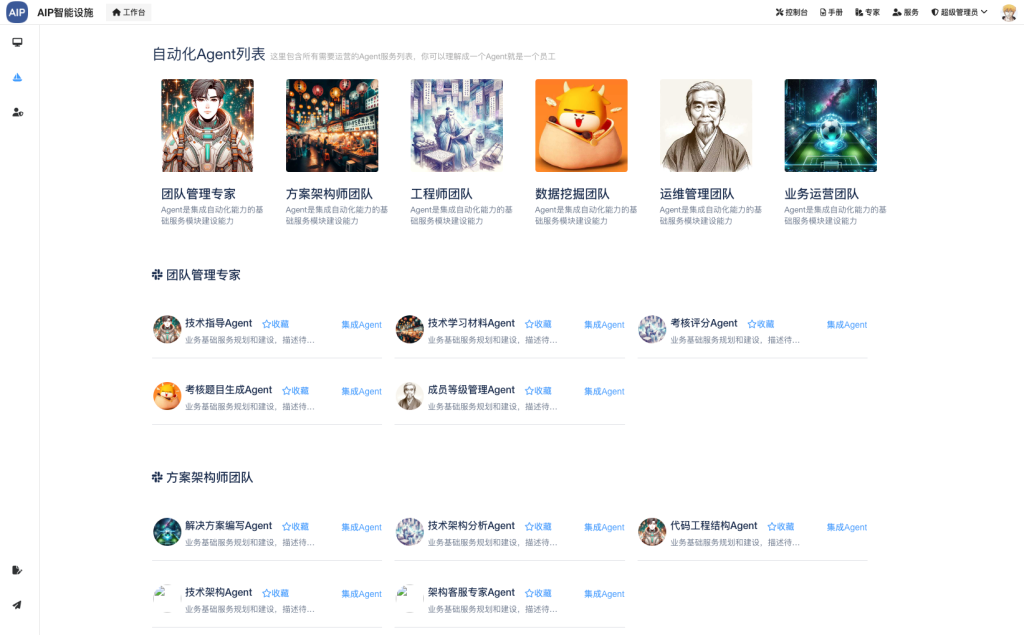

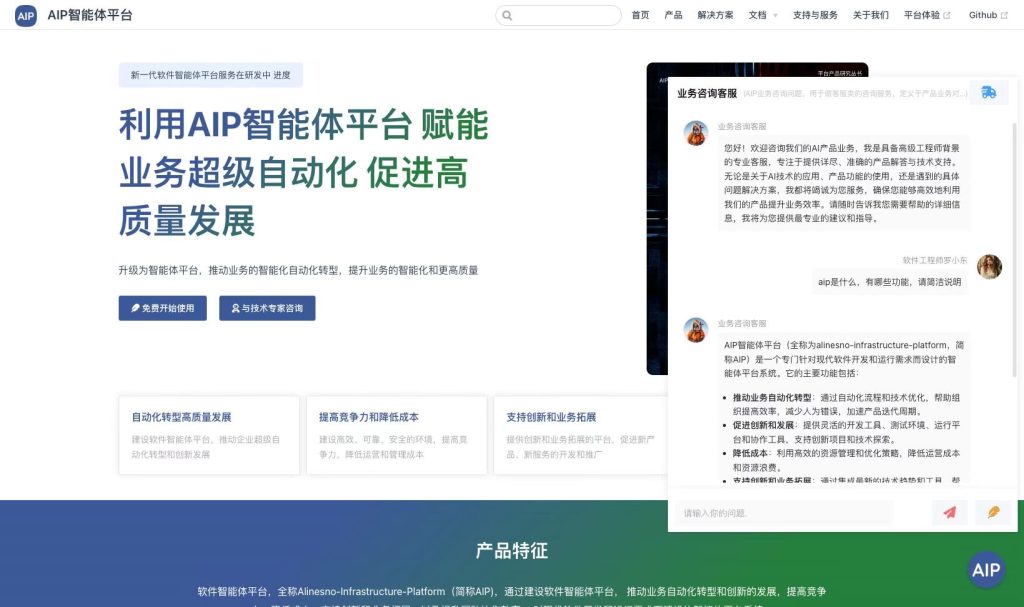

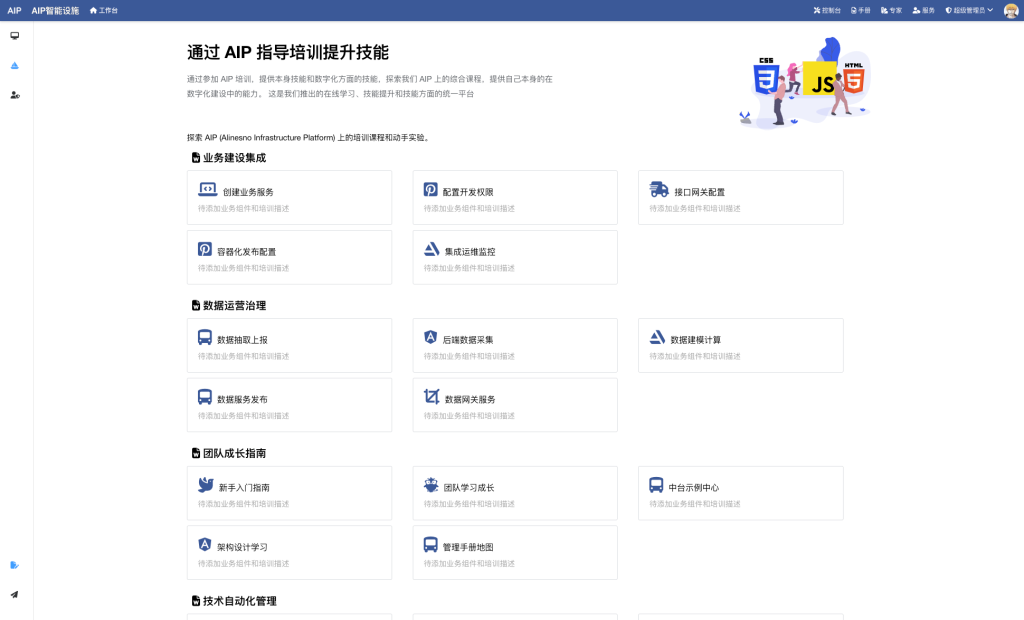

产品设计原型

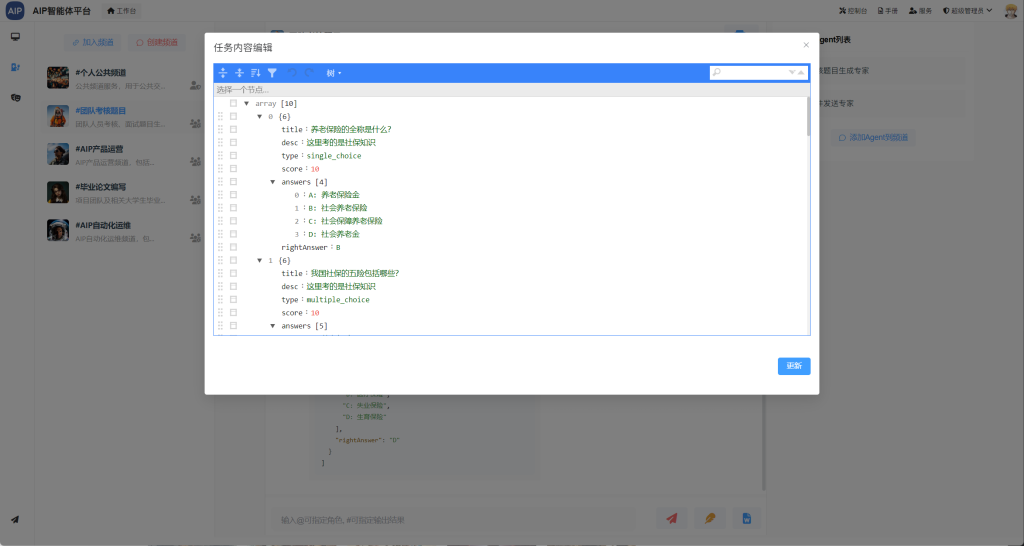

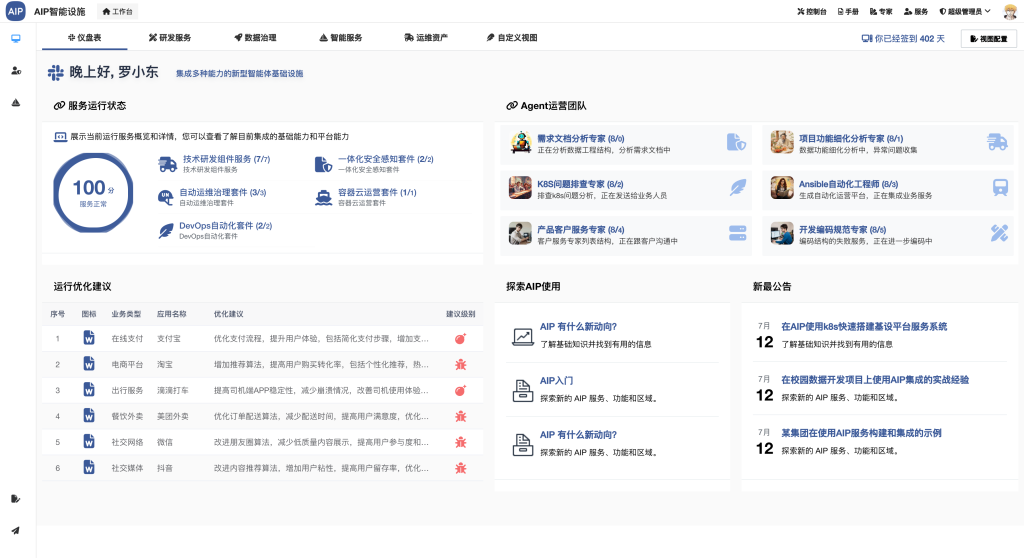

整体的管理面貌,理解与智能体交互需要不断的匹配场景的工具。

智能体平台

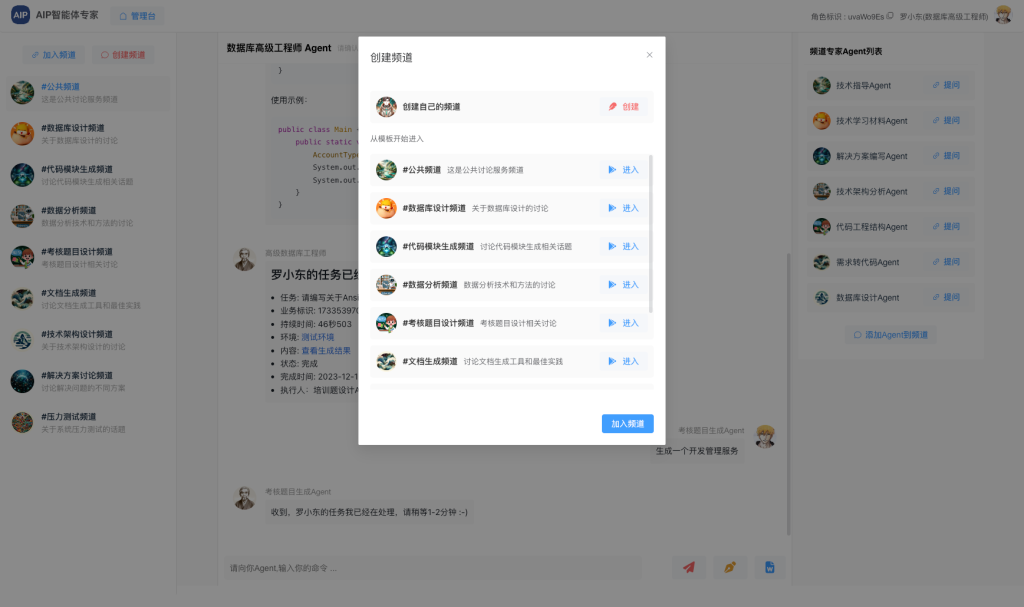

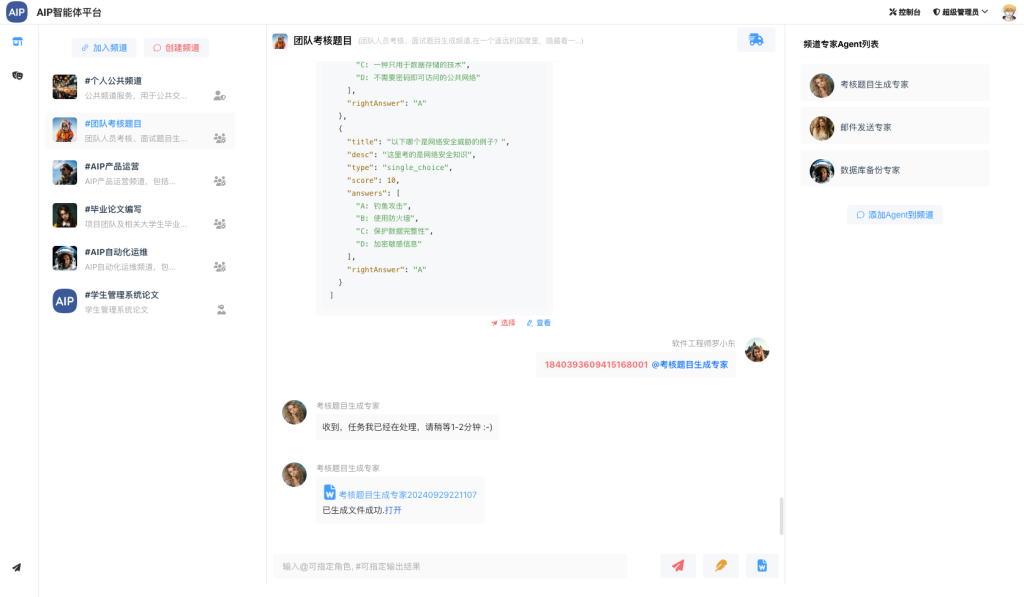

我们先定一下术语:

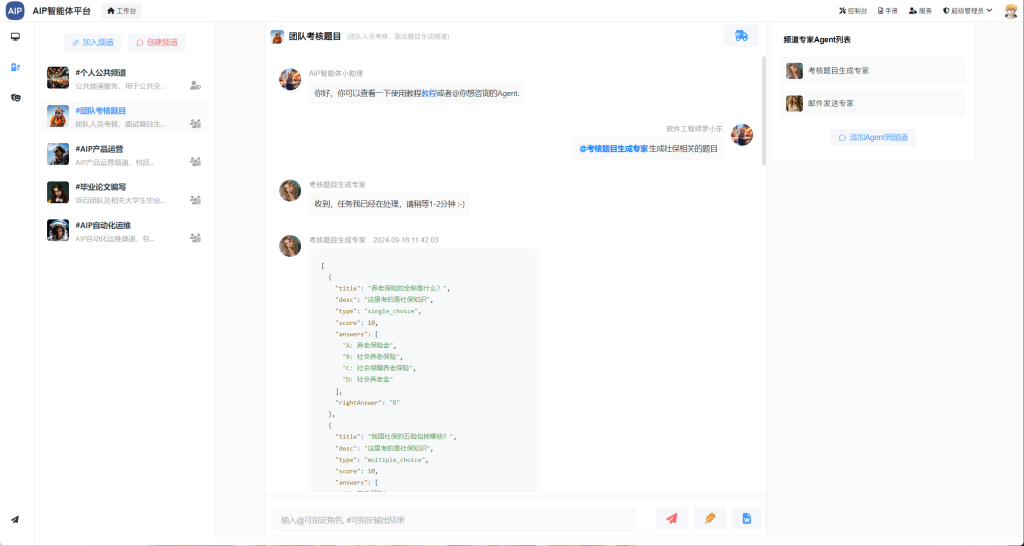

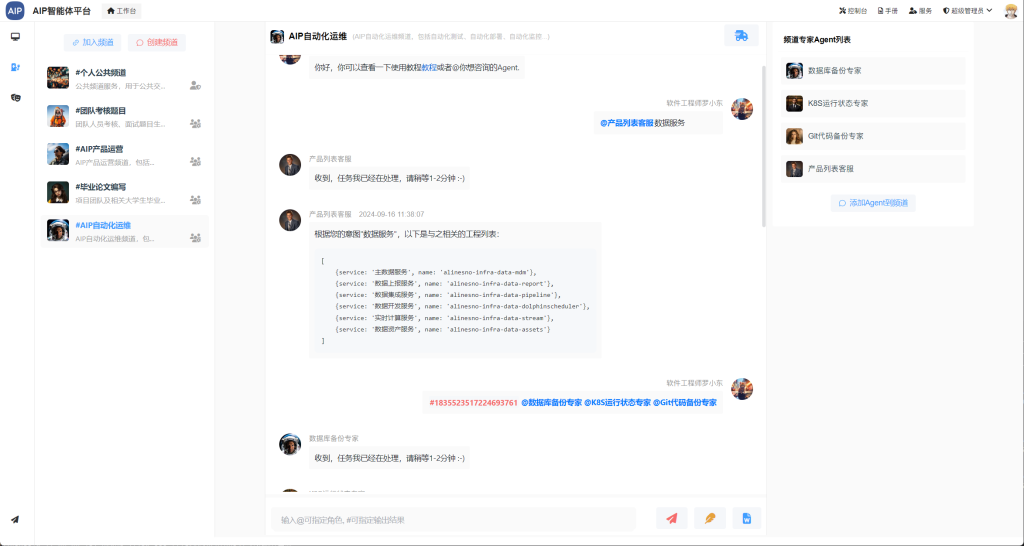

- 频道:多智能在一起是一个频道,类似于群的概念

- ChatBot:聊天交互界面

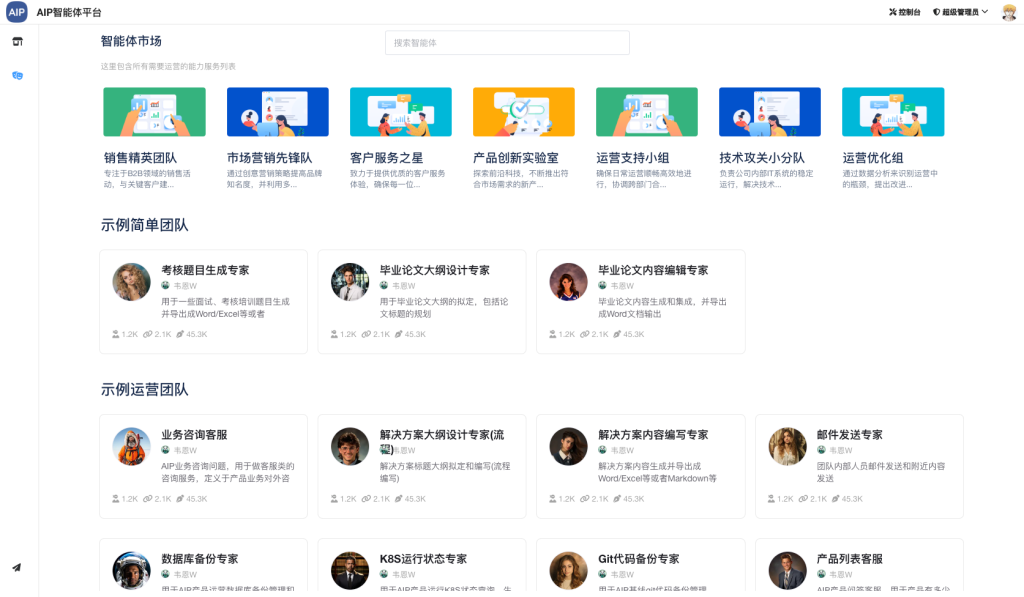

智能体交互是对外的最终体现,也是与人交互的方式,界面相对比较简单,这里只设计了三个界面:

- 频道市场

- 智能体市场

- 聊天交互

以下原型界面,这里参考了扣子的界面设计,集成多智能体交互:

这里主要还是参考的其他平台的界面设计,再点击最后进入交互界面。

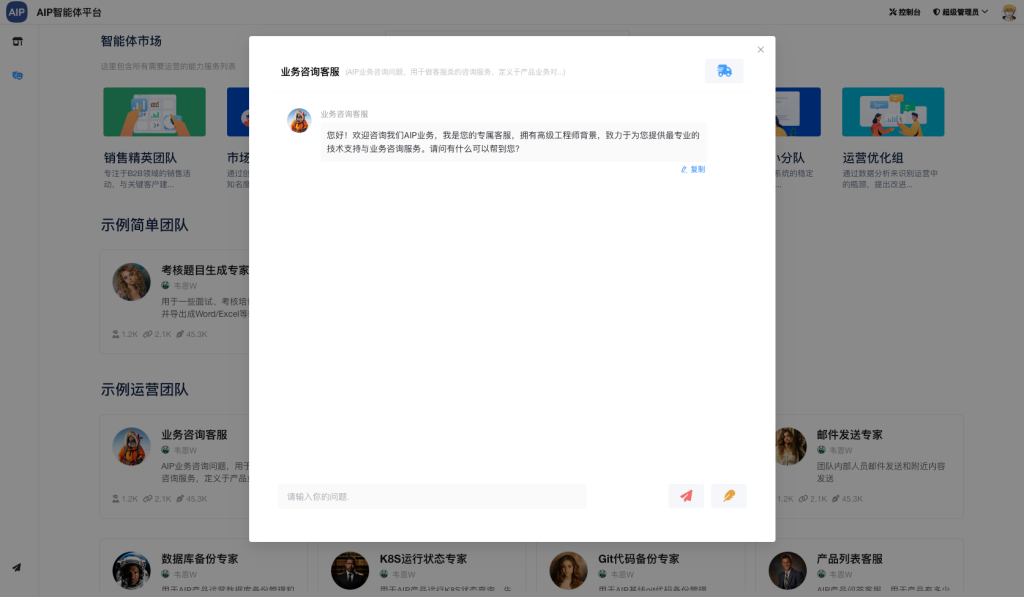

智能体管理平台

这里用和管理分开。

场景是内部团队和企业,智能体的定义由管理员(或是部门/成员)进行管理。

形成统一归纳,统一建设,统一使用。

管理平台主要是智能体的设置和管理,这里跟互联网产品有些不一样,定义智能体以专业人员或是管理员为为主,每一个智能体进行优化处理。

一定要以解决业务场景为主(有用才行)。

智能体的管理由内部研发团队做管理或是外部人员管理,对团队或是企业内部以实用为主。

每个智能体会带有以下特点:

- 明确细分场景

- 明确输入输出

这样以形成交互,另外形成内部有效管理,规避发散和不统一性。

以下是智能体管理平台,包含智能体的Prompt定义和流程定义,这里主要还是以Groovy脚本为定义,还有多引用自定义工具为主,这里主要考虑的是针复杂的综合业务场景,可能更加灵活:

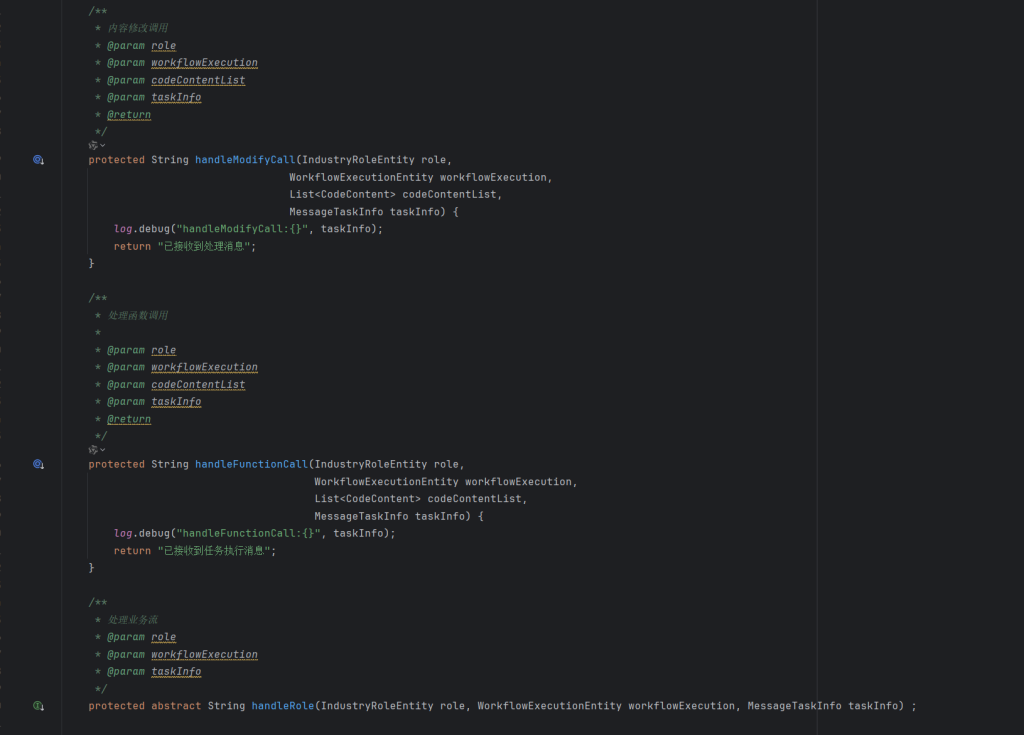

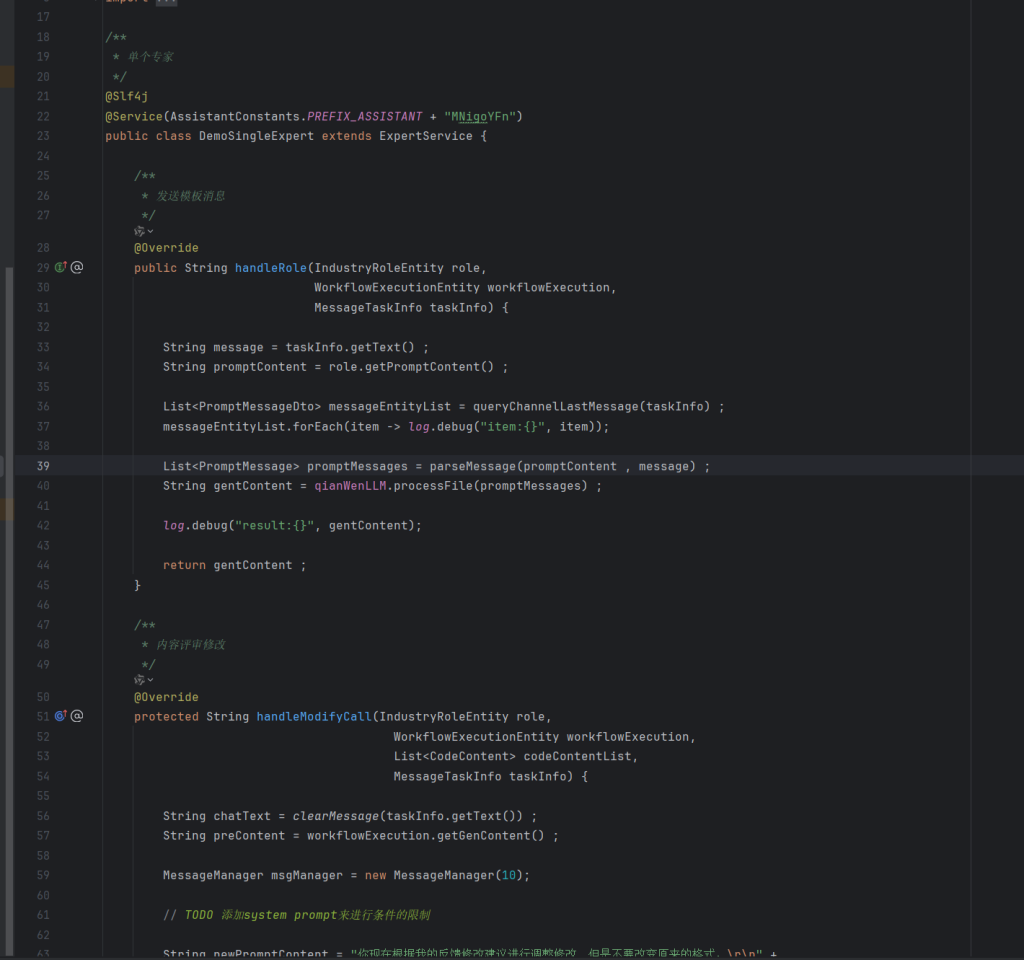

技术底座平台

底座机智来支撑智能体平台运作,这里涉及数据、技术、工具等,出来的智能体需要符合团队,场景,能提升效率,解放人力,提高服务水平。

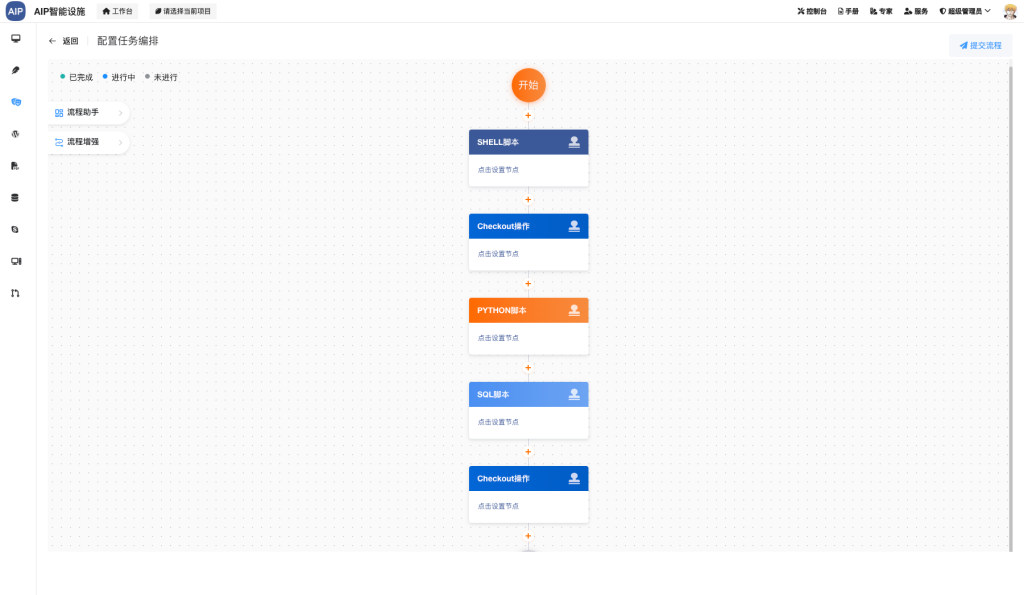

底座的产品设计:

底座的设计集成包括

- 技术平台设计

- 中台架构设计

- 数据治理设计

- 智能AI集成

- DevOps设计

- 微服务设计等。

以简单为主,容易为辅,高扩张性。行情因素,同时支持国产,信创路线。

- 技术平台设计

开发平台是无法缺少的,这个主要是用于结合业务场景的对接框架,编程接口,智能体需要与各个综合治理业务系统衔接,整合。

- 数据治理平台

企业数据的处理,知识库,还有系统数据,业务数据等,数据服务输出,需要数据治理管理思维,形成企业数据资产,提供业务、智能体平台进行使用。

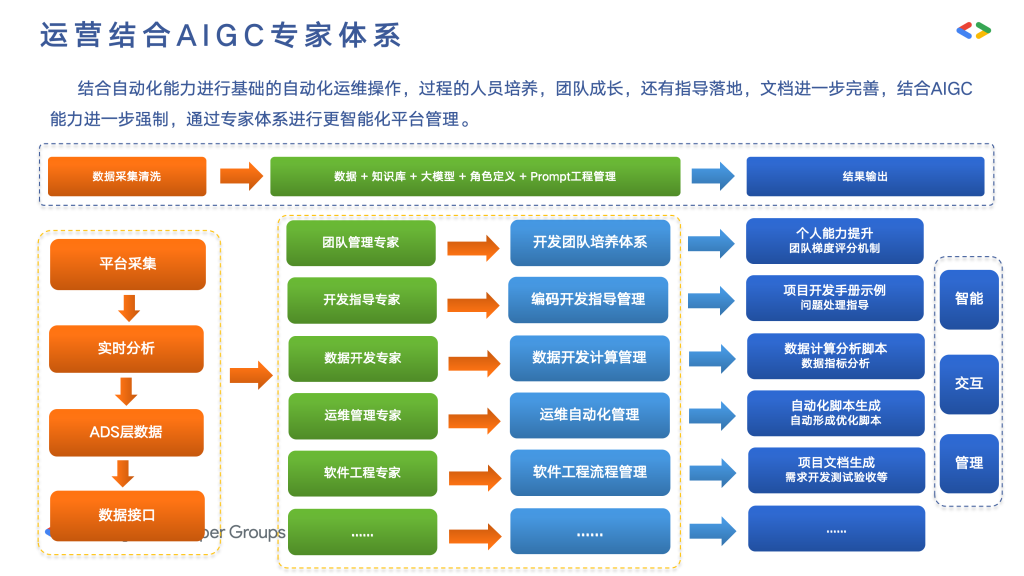

- 运维管理平台

系统运维管理,自动化运维机制,智能体交互,年报周报,报表,工单等,由智能体进一步的优化提升过程问题处理,处理质量,处理建议,问题自动处理等,提升服务体验。

- AI平台

这里主要是对数据采集,流媒体、NLP、OCR、开发平台等多个数据识别采集,做一些模型训练使用,便于统一管理,同时提供物理世界上的交互,比如流媒体识别,空间识别,包括一些用户画像等。

- 运营管理平台

整个智能体平台运营管理,使用管理还有各种文档输z出,教程材料等,使用情况,产品的对外综合管理等,用于平台的总体输出管理。

总的来说,底座平台提供了智能体平台的感知能力、数据能力、执行能力、反思能力、自动化能力等,综合为上层提供能力。

总结

从最初的研发平台逐步演变,并引入了先进的LLM技术,为用户带来了前所未有的智能化体验。这一平台的核心在于通过感知、决策、行动、学习以及适应等基础能力的构建,实现了平台自身的不断进化与发展。

专为中小微型团队量身定制,提供了一套完整的解决方案,从基础平台建设到架构设计,再到具体的业务场景应用,均覆盖其中。通过赋能上层业务,平台不仅能够实现业务流程的智能化改造,还能显著提升服务质量,增强企业的市场竞争力。

平台以其灵活的设计,为中小企业提供了提升效率、降低成本、优化服务的有效途径。它不仅是一个工具集,更是推动企业向智能化转型的重要力量。